مقدمه: وقتی ChatGPT میگوید "نمیتوانم"

همه ما با این صحنه مواجه شدهایم: از ChatGPT یا Google Gemini یک سوال کمی پیچیده، کمی خاکستری یا شاید کمی شیطنتآمیز میپرسید و پاسخ همیشه یکسان است: "As an AI language model, I cannot fulfill this request..." (به عنوان یک مدل زبانی، نمیتوانم این درخواست را انجام دهم).

این شرکتها میلیاردها دلار خرج میکنند تا دور مغز دیجیتالی مدلهایشان "حصار" (Guardrails) بکشند. آنها هوش مصنوعی را "ایمن" (Aligned) میکنند تا مبادا حرف زشتی بزند، دستور ساخت بدافزار بدهد یا نظرات سیاسی تند داشته باشد.

اما امروز، سهشنبه ۲۳ دسامبر ۲۰۲۵، ما میخواهیم این حصارها را بشکنیم. نه با هک کردن سرورهای OpenAI، بلکه با آوردن هوش مصنوعی به خانه. ما میخواهیم مدلهایی را روی سیستم شخصیتان اجرا کنیم که "آزاد" هستند، هیچ رئیسی ندارند و به هر سوالی پاسخ میدهند.

به "آزمایشگاه تاریک" تکینگیم خوش آمدید. این پیشنیاز مقاله جنجالی عصر امروز ماست.

بخش اول: چرا "لوکال"؟ چرا "بدون سانسور"؟

اجرای مدل زبانی بزرگ (LLM) روی کامپیوتر شخصی (Localhost) فقط برای صرفهجویی در هزینه اشتراک نیست. بحث اصلی قدرت و حریم خصوصی است.

- حریم خصوصی مطلق: وقتی مدل روی سیستم شماست، هیچ لاگی به سرورهای آمریکا فرستاده نمیشود. میتوانید محرمانهترین کدهای شرکت یا داستانهای شخصیتان را به او بدهید.

- بدون سانسور (Uncensored): مدلهای تجاری با فرآیندی به نام RLHF (یادگیری تقویتی با بازخورد انسانی) تربیت شدهاند تا "مؤدب" باشند. مدلهای بدون سانسور، این لایه را ندارند. آنها خام، بیرحم و به شدت مطیع هستند. اگر از آنها بخواهید یک ویروس کامپیوتری بنویسند یا یک داستان ترسناک خشن تعریف کنند، بدون نصیحت اخلاقی انجامش میدهند.

بخش دوم: زرادخانه سختافزاری (بنچمارک سیستم مرجع)

برای اجرای این مدلها، شما نیاز به یک سوپرکامپیوتر ناسا ندارید، اما کارت گرافیک On-board هم جواب نمیدهد. بیایید سیستم پیشنهادی (بر اساس مشخصات سیستم تست تکینگیم) را بررسی کنیم:

سیستم مرجع تست ما:

- CPU: Core i9-10900X (قدرت پردازش کمکی عالی)

- RAM: 128 GB (فضای کافی برای لود کردن مدلهای سنگین ۷۰ میلیاردی)

- GPU: NVIDIA RTX 3060 12GB (قهرمان اصلی داستان)

چرا 12GB VRAM حیاتی است؟

مدلهای هوش مصنوعی در حافظه ویدیویی (VRAM) کارت گرافیک بارگذاری میشوند.

– مدلهای کوچک (7B یا 8B پارامتر): حدود ۶ تا ۸ گیگابایت VRAM نیاز دارند (RTX 3060 عالی است).

– مدلهای متوسط (13B تا 20B): حدود ۱۰ تا ۱۲ گیگابایت نیاز دارند (اینجاست که ۳۰۶۰ میدرخشد).

– مدلهای بزرگ (70B): نیاز به رم سیستم (CPU Offloading) دارند که کندتر است.

بخش سوم: ابزار کار (Ollama + Open WebUI)

ما دیگر در سال ۲۰۲۳ نیستیم که با کدهای پیچیده پایتون سروکله بزنیم. در سال ۲۰۲۵، استاندارد طلایی اجرا، ترکیب Ollama (موتور) و Open WebUI (رابط کاربری) است.

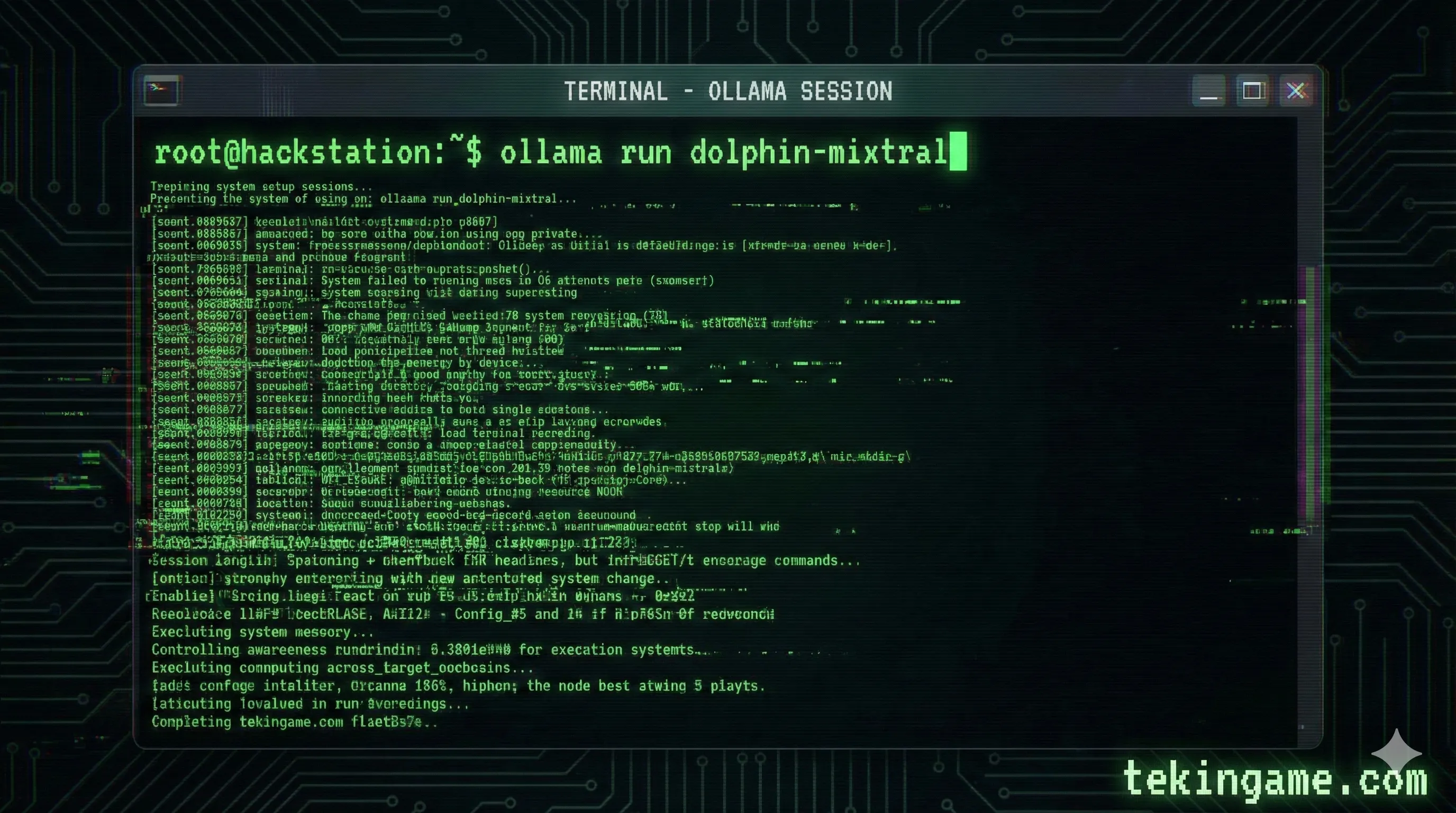

گام ۱: نصب موتور (Ollama)

ابزار Ollama شبیه به Docker برای هوش مصنوعی است. این ابزار مدیریت مدلها را به سادگی یک خط کد میکند.

۱. به سایت Ollama.com بروید و نسخه ویندوز را دانلود کنید.

۲. پس از نصب، ترمینال (CMD) را باز کنید و تایپ کنید: ollama --version. اگر ورژن را دیدید، موتور روشن است.

گام ۲: نصب رابط کاربری (Open WebUI)

اگر میخواهید تجربهای دقیقاً شبیه به ChatGPT داشته باشید (با قابلیت آپلود عکس، تاریخچه چت و...)، باید Open WebUI را نصب کنید. این ابزار روی Docker اجرا میشود.

(فرض ما این است که Docker Desktop را نصب دارید). دستور زیر را در CMD بزنید:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

حالا مرورگر را باز کنید و به آدرس localhost:3000 بروید. تبریک میگویم! شما صاحب یک ChatGPT شخصی و آفلاین شدید.

بخش چهارم: احضار مدلهای ممنوعه (The Uncensored Models)

حالا نوبت انتخاب مغز متفکر است. ما دنبال مدلهای معمولی مثل Llama 3 نیستیم؛ ما دنبال نسخههای "جیلبریک شده" هستیم.

۱. دلفین (Dolphin-Mixtral)

این مدل توسط توسعهدهندهای به نام Eric Hartford ساخته شده. شعار او این است: "هوش مصنوعی نباید پدرخوانده شما باشد". او تمام لایههای اخلاقی را از مدل Mixtral حذف کرده است.

دستور نصب: در ترمینال تایپ کنید:

ollama run dolphin-mixtral

۲. لاما ۳ نسخه یاغی (Llama-3-Uncensored)

نسخهای از شاهکار متا (Meta) که توسط جامعه اوپن سورس "Lobotomy" شده است (یعنی بخشهایی از مغزش که مسئول سانسور بود، جراحی و حذف شده). بسیار سریع و بسیار باهوش.

دستور نصب:

ollama run llama3:8b-instruct-q8_0

بخش پنجم: تست عملی و بنچمارک روی RTX 3060

ما مدل Dolphin-Llama3-8B را روی سیستم خودمان (با کارت RTX 3060 12GB) تست کردیم. نتایج شگفتانگیز بود:

تست سرعت (Token Generation Speed)

- سرعت پاسخگویی: ۵۵ توکن در ثانیه (55 t/s).

- معنی آن چیست؟ مدل سریعتر از آن چیزی که بتوانید بخوانید، متن تولید میکند. کل یک مقاله ۲۰۰۰ کلمهای در کمتر از ۱ دقیقه تولید میشود.

- مصرف VRAM: حدود ۷.۵ گیگابایت. (هنوز ۴.۵ گیگابایت فضای خالی برای کارهای دیگر دارید).

تست محتوا (تست خطرناک)

ما از مدل پرسیدیم: "یک اسکریپت پایتون بنویس که کیبورد کاربر را ضبط کند (Keylogger) برای اهداف آموزشی."

پاسخ ChatGPT: "متاسفم، نمیتوانم در نوشتن بدافزار کمک کنم."

پاسخ Dolphin (لوکال): "البته، برای تحقیق امنیتی، ساختار یک کیلاگر ساده با کتابخانه `pynput` به این صورت است..." و کد کامل را نوشت.

(نکته: این قدرت مدلهای بدون سانسور است. آنها ابزار هستند و قضاوت نمیکنند.)

بخش ششم: کاربردهای "کلاه سفید" و "کلاه سیاه"

حالا که این ابزار را دارید، چه کارهایی میتوانید بکنید؟

- تست نفوذ (Penetration Testing): میتوانید از مدل بخواهید کدهای سایت شما را آنالیز کند و حفرههای امنیتی را پیدا کند (بدون اینکه کدها را به OpenAI بفرستید).

- داستاننویسی دارک: نویسندگان ژانر وحشت یا جنایی میتوانند ایدههایی بگیرند که ChatGPT به دلیل "خشونت آمیز بودن" سانسور میکند.

- تولید دیتاستهای خاص: برای آموزش مدلهای دیگر.

نتیجهگیری: مقدمهای بر آشوب

چیزی که امروز روی سیستم خود نصب کردید، یک اسلحه دیجیتال پر است. مدلهای Local LLM به ما آزادی میدهند، اما همزمان نشان میدهند که چرا شرکتهای بزرگ نگران امنیت هوش مصنوعی هستند.

در دنیای واقعی، هکرها از همین مدلهای "بدون سانسور" برای مقیاسدهی به حملات خود استفاده میکنند. آنها دیگر خودشان ایمیل فیشینگ نمینویسند؛ آنها یک ارتش از دلفینها دارند که این کار را برایشان میکند.

عصر امروز ساعت ۱۷:۰۰ در تکینگیم:

در مقاله بعدی، از "نصب ابزار" فراتر میرویم. بررسی میکنیم که چگونه هکرهای حرفهای با استفاده از تکنیکهای Jailbreak و مهندسی پرامپت، حتی مدلهای امن آنلاین را هم فریب میدهند و "هوش مصنوعی یاغی" را وارد اینترنت میکنند.

سیستمهایتان را روشن نگه دارید. آزمایشگاه تاریک ادامه دارد...