۱. چرا هوش مصنوعی لوکال (Local LLM) آینده برنامهنویسی است؟

شاید بپرسید وقتی ChatGPT و GitHub Copilot هستند، چرا باید به خودمان زحمت بدهیم و مدل هوش مصنوعی را روی سیستم شخصی نصب کنیم؟ پاسخ در سه کلمه خلاصه میشود: امنیت، هزینه و آزادی.

وقتی شما کدی را در چتجیپیتی پیست میکنید، آن کد به سرورهای شرکت OpenAI ارسال میشود. برای پروژههای شخصی شاید مهم نباشد، اما برای کدهای شرکتی یا ایدههای محرمانه، این یک کابوس امنیتی است. در روش "Local LLM"، دیتای شما حتی یک بایت هم از کامپیوترتان خارج نمیشود.

- رایگان برای همیشه: مدلهای Open Source هیچ هزینه اشتراکی ندارند.

- بدون قطعی اینترنت: حتی اگر اینترنت کل کشور قطع شود، دستیار هوشمند شما کار میکند.

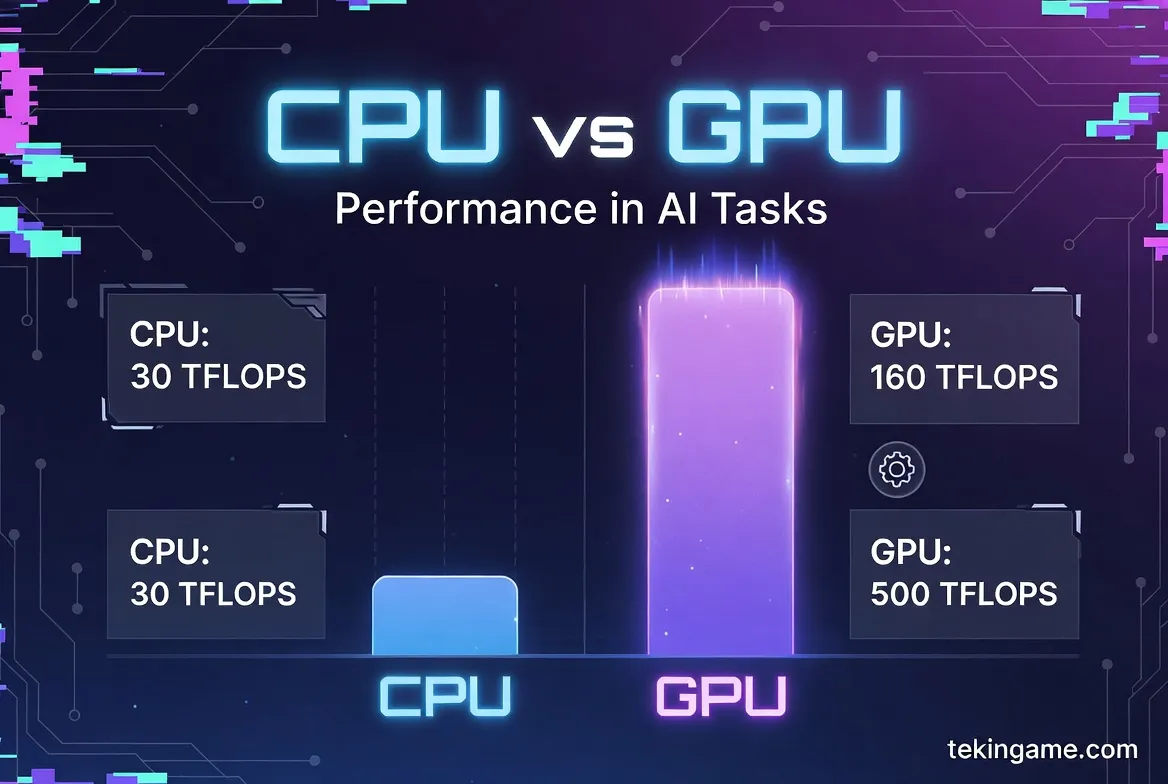

- سرعت بالا: اگر کارت گرافیک خوبی داشته باشید، سرعت تولید کد از APIهای اینترنتی هم بیشتر است.

۲. پیشنیازهای سختافزاری (آیا سیستم من میکشد؟)

اجرای مدلهای زبانی بزرگ، خوراک سختافزار است. برخلاف بازیها که هم به CPU و هم GPU فشار میآورند، هوش مصنوعی تشنهی VRAM (حافظه کارت گرافیک) و پهنای باند حافظه است.

حداقل سیستم پیشنهادی تکینگیم:

- کارت گرافیک (GPU): انویدیا سری RTX 3060 (با 12 گیگابایت VRAM) نقطه شروع طلایی است. مدلهای 8 گیگابایتی هم کار میکنند اما محدودترند.

- رم سیستم (RAM): حداقل 16 گیگابایت (32 گیگابایت ایدهآل است).

- فضای ذخیرهسازی: حداقل 20 گیگابایت فضای خالی روی SSD پرسرعت.

۳. معرفی ابزارها: ترکیب برنده Ollama و Devstral

در گذشته برای اجرای یک مدل AI باید با پایتون، درایورهای CUDA و محیطهای مجازی سروکله میزدید. اما ابزاری به نام Ollama بازی را عوض کرد. اولاما یک پلتفرم ساده است که مدلهای پیچیده را بستهبندی کرده و با یک خط دستور اجرا میکند.

مدل انتخابی ما، Devstral 2 (یا نسخه پایه Mistral) است. این مدل فرانسوی در تستهای برنامهنویسی (HumanEval) عملکردی نزدیک به GPT-3.5 و حتی GPT-4 دارد، اما طوری بهینهسازی شده که روی سیستمهای خانگی اجرا شود.

۴. مرحله اول: نصب و راهاندازی Ollama

بیایید دست به کار شویم. این مراحل برای ویندوز ۱۰ و ۱۱ است (نسخههای مک و لینوکس هم مشابه هستند):

- وارد سایت رسمی Ollama.com شوید.

- دکمه Download for Windows را بزنید.

- فایل نصبکننده را اجرا کنید. پس از نصب، آیکون کوچک Ollama در سینی ویندوز (Taskbar) ظاهر میشود.

حالا باید مطمئن شویم نصب موفقیتآمیز بوده است. کلیدهای Win + R را بزنید، بنویسید cmd و اینتر کنید. در محیط ترمینال تایپ کنید:

ollama --version

اگر نسخه برنامه را دیدید، همه چیز آماده است.

۵. مرحله دوم: دانلود و اجرای مدل Devstral 2

در این مرحله باید مدل هوش مصنوعی را دانلود کنیم. از آنجایی که Devstral بر پایه Mistral است، ما از دستور استاندارد استفاده میکنیم (اگر مدل خاص Devstral در مخزن اولاما موجود شد، نام آن را جایگزین کنید).

در همان پنجره ترمینال (CMD)، دستور زیر را وارد کنید:

ollama run mistral

چه اتفاقی میافتد؟

- برنامه شروع به دانلود فایل مدل (حدود ۴.۱ گیگابایت) میکند.

- پس از دانلود، مدل بهصورت خودکار روی کارت گرافیک شما بارگذاری (Load) میشود.

- یک علامت پرامپت ظاهر میشود که میتوانید با هوش مصنوعی چت کنید.

برای تست بنویسید: Write a python code for snake game. اگر شروع به نوشتن کد کرد، تبریک میگویم! شما صاحب یک هوش مصنوعی شخصی شدید.

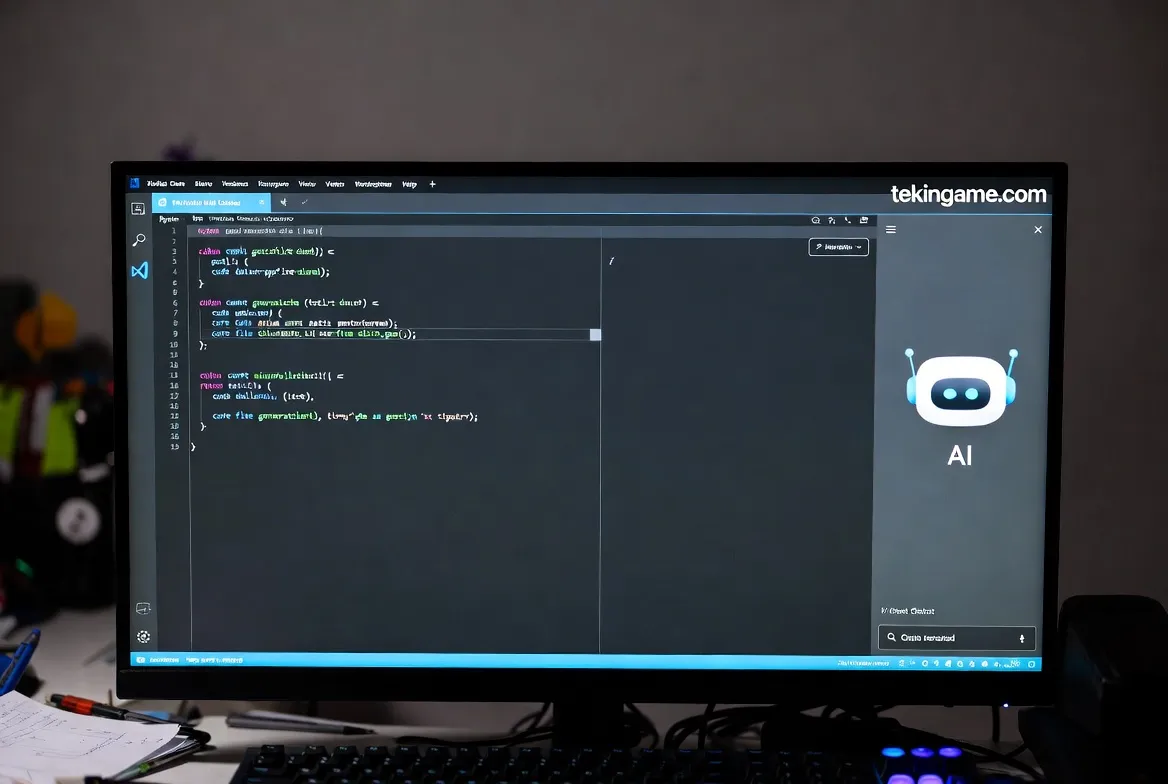

۶. مرحله سوم: اتصال به VS Code (جایگزین رایگان Copilot)

اجرای مدل در صفحه سیاه ترمینال جذاب است، اما کاربردی نیست. ما آن را داخل ادیتور کد خودمان میخواهیم. برای این کار از شاهکار متنباز دیگری به نام افزونه Continue استفاده میکنیم.

- نرمافزار VS Code را باز کنید.

- به بخش Extensions (سمت چپ) بروید و عبارت

Continueرا جستجو کنید. - افزونهای که با نام "Continue - The open-source AI code assistant" است را نصب کنید.

- پس از نصب، آیکون آن در نوار سمت چپ ظاهر میشود. روی آن کلیک کنید.

- در پایین پنل چت، روی نام مدل کلیک کنید و Add Model را بزنید.

- در لیست Providerها، گزینه Ollama را انتخاب کنید.

- گزینه Autodetect را بزنید. افزونه خودش مدل Mistral که نصب کرده بودید را پیدا میکند.

تمام شد! حالا چطور استفاده کنیم؟

- چت با کد: قسمتی از کد را هایلایت کنید، کلید

Ctrl + Lرا بزنید و بپرسید "این کد چه کاری انجام میدهد؟" - کدنویسی خودکار: در ادیتور کلید

Ctrl + Iرا بزنید و دستور بدهید: "یک تابع برای اتصال به دیتابیس بساز".

۷. ترفندهای حرفهای: افزایش حافظه و پرامپتهای سیستمی

حالا که سیستم راه افتاد، بیایید مثل یک حرفهای آن را تیونینگ کنیم.

افزایش Context Window (حافظه کوتاهمدت)

بهصورت پیشفرض، مدل فقط ۴۰۹۶ توکن (حدود ۳۰۰۰ کلمه) از مکالمه را به یاد میسپارد. اگر رم بالایی دارید (مثلاً ۳۲ گیگابایت)، میتوانید این عدد را افزایش دهید تا هوش مصنوعی بتواند کل فایلهای پروژه شما را بخواند.

برای این کار در ترمینال دستور ollama run mistral را متوقف کنید و یک Modelfile جدید بسازید که پارامتر num_ctx را روی 16384 تنظیم کند. (آموزش ساخت Modelfile را در ویدیوی یوتیوب تکینگیم ببینید).

دستور سیستمی (System Prompt)

به هوش مصنوعی بگویید کیست! در تنظیمات افزونه Continue، بخش System Prompt را اینگونه تنظیم کنید:

"You are an expert Senior Developer. You adhere to Clean Code principles. Always explain your code briefly and focus on performance."

۸. جمعبندی و سوالات متداول

دنیای هوش مصنوعی لوکال تازه در ابتدای راه است. با نصب این ابزارها، شما نه تنها در هزینهها صرفهجویی میکنید، بلکه حریم خصوصی پروژه خود را تضمین کردهاید. مدلهایی مثل Devstral 2 هر روز پیشرفتهتر میشوند و فاصله خود را با مدلهای غولپیکری مثل GPT-4 کم میکنند.

سوالات شما:

- آیا روی کارت گرافیک AMD هم کار میکند؟ بله، نسخه جدید Ollama از کارتهای AMD سری RX 6000 و بالاتر پشتیبانی میکند.

- آیا سرعت آن کند است؟ سرعت رابطه مستقیم با کارت گرافیک دارد. روی RTX 3060 سرعت بسیار قابل قبول است، اما روی CPU ممکن است کند باشد.

تجربه شما چیست؟ آیا توانستید مدل را نصب کنید؟ اگر در مرحلهای گیر کردید، در بخش نظرات همین پست بنویسید تا تیم فنی تکینگیم راهنماییتان کند.