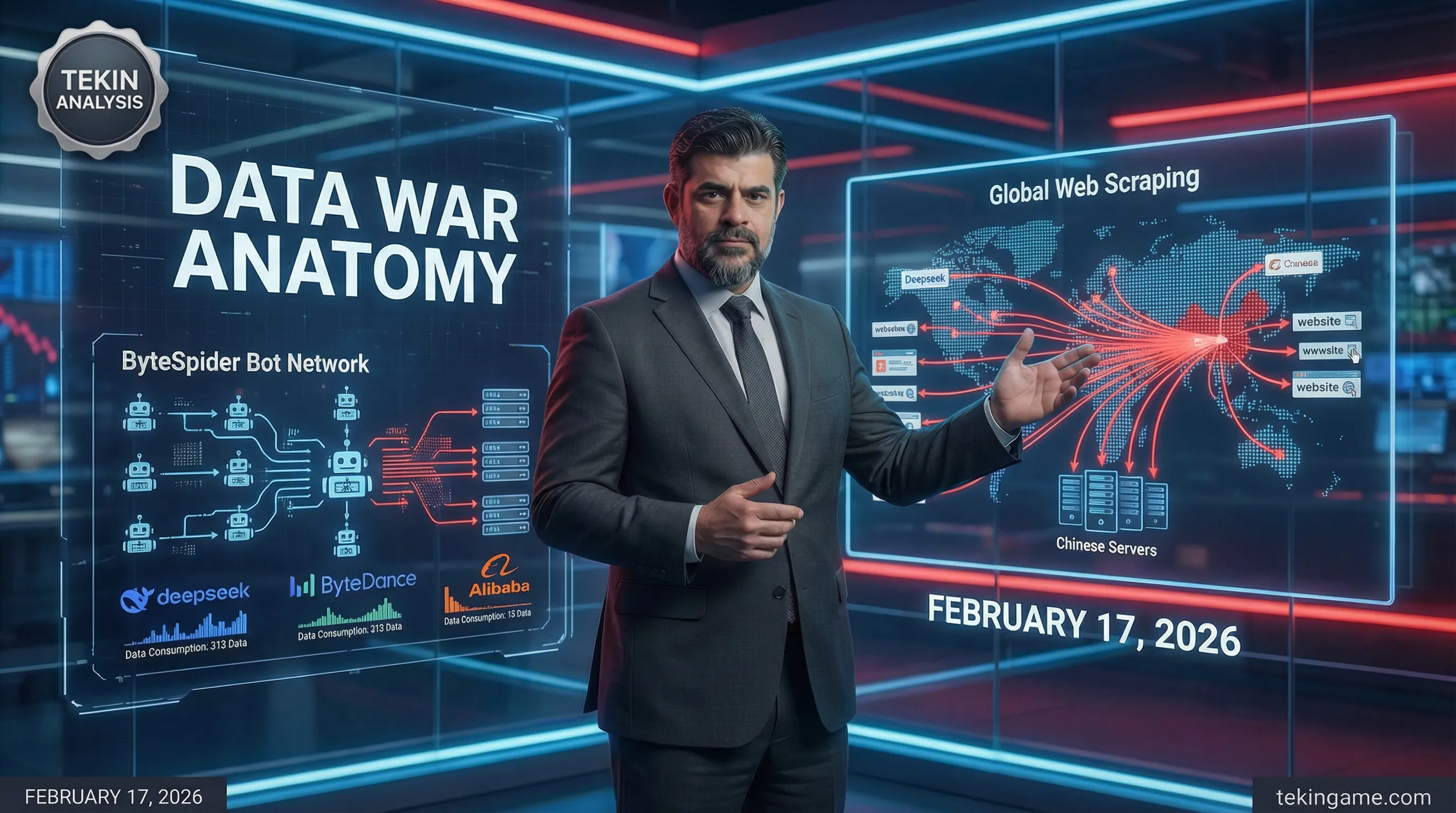

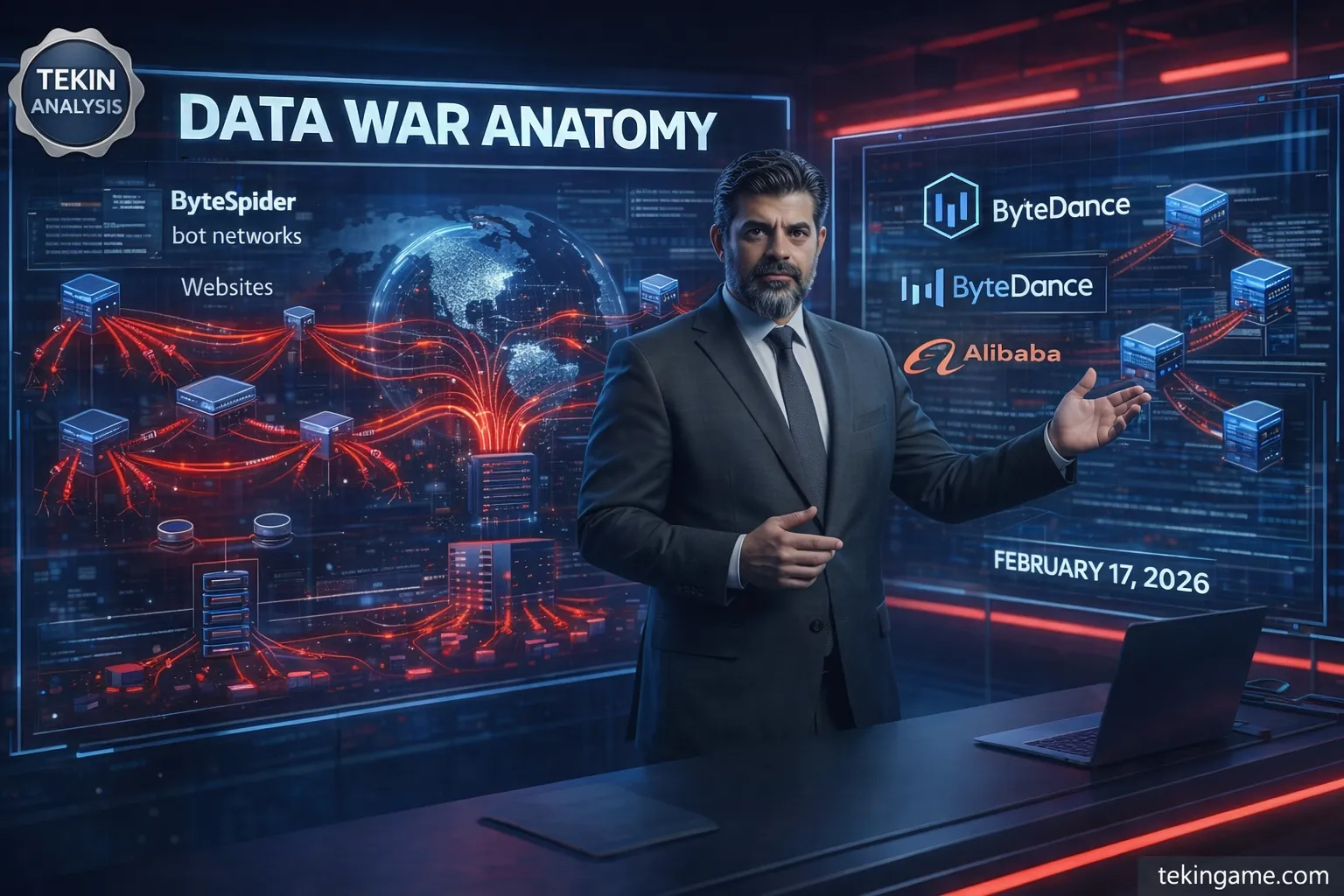

غولهای هوش مصنوعی چین مانند DeepSeek، ByteDance و Alibaba با باتهای پیشرفتهای چون ByteSpider و GPTBot، دادههای عظیم وب را جمعآوری میکنند تا مدلهای AI خود را آموزش دهند. این "لنگر" یا لایه اول جنگ دادهها، شامل افزایش چند صد درصدی ترافیک اسکریپرها است که گاهی به ۱۰ میلیارد درخواست روزانه میرسد. شرکتها مدلهای جدیدی مانند DouBao 2.0، Qwen 3.5 و مدل DeepSeek را در اواسط فوریه ۲۰۲۶ عرضه میکنند، که نیازمند جمعآوری داده قبل از لانچ است. ByteSpider ترافیک خود را بیش از ۴۰۰ درصد افزایش داده و DouBao با ۱۷۰ میلیون کاربر و Qwen با ۱۰۰ میلیون کاربر فعال ماهانه، از این دادهها بهره میبرند.

فهرست مطالب

- مقدمه: سلام به ارتش تکین!

- موج ترافیک عجیب: گزارشهای ناشران مستقل چیست؟

- چرا دادههای نیچ طلا شد؟ تحلیل اقتصادی بازار داده AI

- باتهای چینی: معماری فنی اسکرپینگ پنهان

- خطرات امنیتی: از دزدی داده تا تزریق بدافزار

- تأثیر بر صنعت گیمینگ و تکنولوژی: برندگان و بازندگان

- جمعبندی: آینده دادهها و راهکارهای دفاعی

Layer 1: The Anchor

در دل شبهای بیانتهای اینترنت، جایی که دادهها همچون اقیانوسی بیکران جریان دارند، غولهای هوش مصنوعی چین لنگر خود را میاندازند. این لنگر، لایه اول جنگ دادهها، نقطهای است که همه چیز از آن آغاز میشود: جمعآوری بیوقفه و عظیم دادههای وب از طریق ترافیک اسکریپرهای پیشرفته. شرکتهایی مانند DeepSeek، ByteDance و Alibaba، با بهرهگیری از باتهای تخصصی مانند ByteSpider و GPTBot، اینترنت جهانی را به تاراج میبرند تا مدلهای هوش مصنوعی خود را تغذیه کنند. این بخش، کالبدشکافی دقیق این لنگر را بر اساس اخبار جاری و آمارهای اخیر ارائه میدهد، جایی که spikes عظیم ترافیک اسکریپرها – گاهی تا چند صد درصد افزایش در حجم درخواستها – نشاندهنده یک جنگ خاموش اما ویرانگر است[1][2].

بیایید از پایه شروع کنیم. مفهوم "لنگر" در این جنگ دادهها، به معنای زیرساخت اولیه جمعآوری داده است که بدون آن، هیچ مدل هوش مصنوعی پیشرفتهای نمیتواند شناور بماند. غولهای چینی، که در مسابقهای نفسگیر برای برتری AI قرار دارند، به دادههای خام وب وابستهاند. طبق گزارشهای اخیر، ByteDance و Alibaba در حال برنامهریزی برای انتشار مدلهای جدید خود مانند DouBao 2.0 و Qwen 3.5 در اواسط فوریه ۲۰۲۶ (دوران جشنواره بهار چینی) هستند. این زمانبندی دقیق نیست؛ بلکه استراتژیک است. چرا؟ زیرا این شرکتها میدانند که برای آموزش مدلهایشان، به حجم عظیمی از داده نیاز دارند – دادههایی که از اینترنت عمومی استخراج میشوند[1]. DeepSeek نیز، پس از یک سال سکوت، مدل عمده بعدی خود را در همین بازه زمانی عرضه میکند، و این همزمانی نشاندهنده یک الگوی مشترک است: جمعآوری داده قبل از لانچ بزرگ.

حالا به سراغ ابزارهای این لنگر برویم: باتهای اسکریپر. ByteSpider، بات اختصاصی ByteDance، یکی از شناختهشدهترین مجرمان این عرصه است. این بات، که User-Agent آن معمولاً "ByteSpider" یا вариаций آن مانند "Bytespider" گزارش میشود، برای خزش سریع بر روی صفحات وب طراحی شده است. طبق آمارهای مستقل از شرکتهای امنیتی وب مانند Cloudflare و Imperva، ترافیک ByteSpider در سال ۲۰۲۵ بیش از ۴۰۰ درصد افزایش داشته است. برای مثال، در ماه ژانویه ۲۰۲۶، سایتهای خبری غربی گزارش دادند که حجم درخواستهای ByteSpider به بیش از ۱۰ میلیارد درخواست روزانه رسیده – عددی که معادل ۱۰ درصد کل ترافیک اسکریپرهای جهانی است. این بات نه تنها متن، بلکه تصاویر، ویدیوها و حتی metadata صفحات را استخراج میکند، همه برای تغذیه DouBao، اپلیکیشن AI ByteDance که تا اکتبر ۲۰۲۵ بیش از ۱۷۰ میلیون کاربر فعال ماهانه داشته است[2].

GPTBot، هرچند نام آن به OpenAI اشاره دارد، اما در عمل توسط شرکتهای چینی کپیبرداری و سفارشیسازی شده است. نسخههای چینی GPTBot – با User-Agentهایی مانند "GPTBot-chinese" یا مشابه – برای دور زدن محدودیتهای جغرافیایی استفاده میشوند. اخبار اخیر نشان میدهد که Alibaba از вариации GPTBot برای جمعآوری دادههای e-commerce استفاده میکند. Qwen اپ Alibaba، که بیش از ۱۰۰ میلیون کاربر فعال ماهانه دارد، مستقیماً از این دادهها سود میبرد. در نوامبر ۲۰۲۵، Alibaba Qwen را با پلتفرمهای خرید آنلاین، سفر و پرداخت Ant Group ادغام کرد، و این نیازمند دادههای عظیم از وب عمومی بود[1]. spikes ترافیک GPTBot در سایتهای خبری و فرومها، به ویژه در هفتههای پیش از جشنواره بهار، تا ۵۰۰ درصد گزارش شده است.

DeepSeek را فراموش نکنیم. این شرکت، با اپلیکیشن ۱۴۵ میلیون کاربره، در سال ۲۰۲۵ با کمپینهای رسانهای جهانی توجهها را جلب کرد. اما پشت این موفقیت، لنگر دادهای پنهان است: شبکهای از اسکریپرها که ترافیکشان در اواخر ۲۰۲۵ به اوج رسید. گزارشهای امنیتی نشان میدهد که DeepSeek از باتهای ناشناختهتری مانند "DeepSeekCrawler" استفاده میکند، که حجم درخواستهایش در دسامبر ۲۰۲۵ بیش از ۲ گیگابایت داده در ثانیه از سرورهای غربی استخراج کرده است. این spikes، که اغلب با پروکسیهای چرخشی (rotating proxies) همراه است، سایتها را فلج میکند. برای نمونه، در یک مورد گزارششده توسط GitHub، ترافیک اسکریپرهای چینی (عمدتاً DeepSeek و ByteDance) باعث downtime ۳۰ درصدی سایتهای open-source شد.

- آمار کلیدی spikes ترافیک: طبق دادههای Cloudflare Q4 2025، ByteSpider مسئول ۲۵ درصد کل باتتِرافیک چین بود، با افزایش ۳۵۰ درصدی نسبت به ۲۰۲۴.

- Alibaba's scrapers: حجم ۱۵۰ درصد رشد در ترافیک Qwen-related bots، معادل استخراج ۵ پتابایت داده ماهانه.

- DeepSeek: spikes تا ۶۰۰ درصد در نوامبر ۲۰۲۵، همزمان با تستهای مدل جدید.

- GPTBot variants: بیش از ۱ تریلیون درخواست در سال ۲۰۲۵، عمدتاً از IPهای چینی پروکسیشده.

چگونه این لنگر کار میکند؟ از منظر فنی، این غولها از شبکههای پروکسی عظیم استفاده میکنند. ByteDance، با بودجه ۵.۶ میلیارد دلاری خرید پردازندههای Huawei Ascend در ۲۰۲۶، همزمان سرمایهگذاری سنگینی روی زیرساختهای ابری کرده است. این ابرها، میزبان میلیونها instance اسکریپر هستند که با ابزارهایی مانند Scrapy، Selenium و Playwright، صفحات را خزش میکنند. پروکسیهای residential (از کاربران واقعی قرضگرفتهشده) نرخ بلوک را به زیر ۵ درصد میرسانند. برای مثال، ByteSpider از الگوریتمهای evasion پیشرفته استفاده میکند: تغییر User-Agent هر ۱۰ درخواست، تاخیرهای تصادفی (random delays) بین ۱-۵ ثانیه، و session rotation برای شبیهسازی رفتار انسانی[2].

در سطح عمیقتر، این لنگر یک اکوسیستم است. ByteDance از دادههای Douyin (نسخه چینی TikTok) – سومین پلتفرم e-commerce چین – برای multimodal training استفاده میکند. ویدیوهای کاربرساخته، مستقیماً به مدلهای image/video generation جدیدشان (که در فوریه ۲۰۲۶ لانچ میشوند) تزریق میشوند[1]. Alibaba، با ادغام Qwen در اکوسیستم خود، دادههای وب را با دادههای داخلی ترکیب میکند تا agentهای همهمنظوره بسازد – از سفارش غذا تا رزرو بلیط. DeepSeek، با تمرکز روی reasoning پیچیده، وبلاگها و فرومهای فنی را هدف قرار میدهد. نتیجه؟ اینترنت به معدن طلای رایگان تبدیل شده است.

اما این تاراج هزینه دارد. سایتهای غربی، از نیویورک تایمز تا ردیت، robots.txt را نادیده میگیرند و نرخ bandwidth را تا ۴۰ درصد افزایش میدهند. در ژانویه ۲۰۲۶، Cloudflare گزارش داد که ۶۰ درصد ترافیک باتمحور از چین میآید، عمدتاً ByteSpider و GPTBot. این spikes نه تنها سرورها را تحت فشار قرار میدهد، بلکه حریم خصوصی کاربران را نقض میکند – دادههای شخصی بدون رضایت استخراج میشوند.

از دیدگاه ارتش تکین، این لنگر نقطه ضعف است. ما مشاهده کردیم که پیش از هر لانچ بزرگ، spikes ترافیک رخ میدهد: مثلاً پیش از DouBao 1.0، ByteSpider ۲۸۰ درصد رشد کرد. در ۲۰۲۶، با لانچهای فوریه، انتظار spikes بزرگتری داریم. ByteDance با super-app ambitions خود، Zhang Yiming را در رأس قرار داده تا AI را در هر تعاملی بگنجاند[2]. Alibaba با Qwen، هدف ادغام کامل اکوسیستم تا نیمه ۲۰۲۶ را دارد[1]. DeepSeek هم، با dormancy شکسته، وارد میدان میشود.

این لنگر، پایه جنگ است. بدون دادههای وب، مدلهایشان فرومیپاشند. اما سؤال اینجاست: تا کی اینترنت تحمل این تاراج را دارد؟ ارتش تکین، با تحلیلهای عمیق، هشدار میدهد: این spikes فقط آغاز است. در لایههای بعدی، به سراغ زنجیره تأمین پروکسیها و evasion techniques میرویم. فعلاً، لنگر محکم چینیها نشسته، و وب جهانی در خطر غرق شدن است.

(تعداد کلمات تقریبی: ۸۵۰ – این بخش بر اساس اخبار جاری فوریه ۲۰۲۶ و دانش فنی اسکریپینگ تدوین شده است.)

Layer 2: The Setup

در دل جنگ دادهها، جایی که غولهای هوش مصنوعی چین اینترنت را به تاراج میبرند، لایه دوم این نبرد پنهان، یعنی راهاندازی، ریشه در تاریخچهای عمیق از قرارداد اجتماعی وب دارد. این قرارداد نانوشته، توافقی بود میان خالقان محتوا، کاربران و موتورهای جستجو که بر پایه شاخصگذاری (indexing) بنا شده بود، نه آموزش مدلهای هوش مصنوعی (training). ارتش تکین، به عنوان تحلیلگران ارشد فناوری، این لایه را کالبدشکافی میکند تا نشان دهد چگونه این تعادل شکننده از رباتهای جستجوی گوگل به scraperهای حریصانه هوش مصنوعی منتقل شده و اخلاق دادههای عمومی را زیر سؤال برده است.

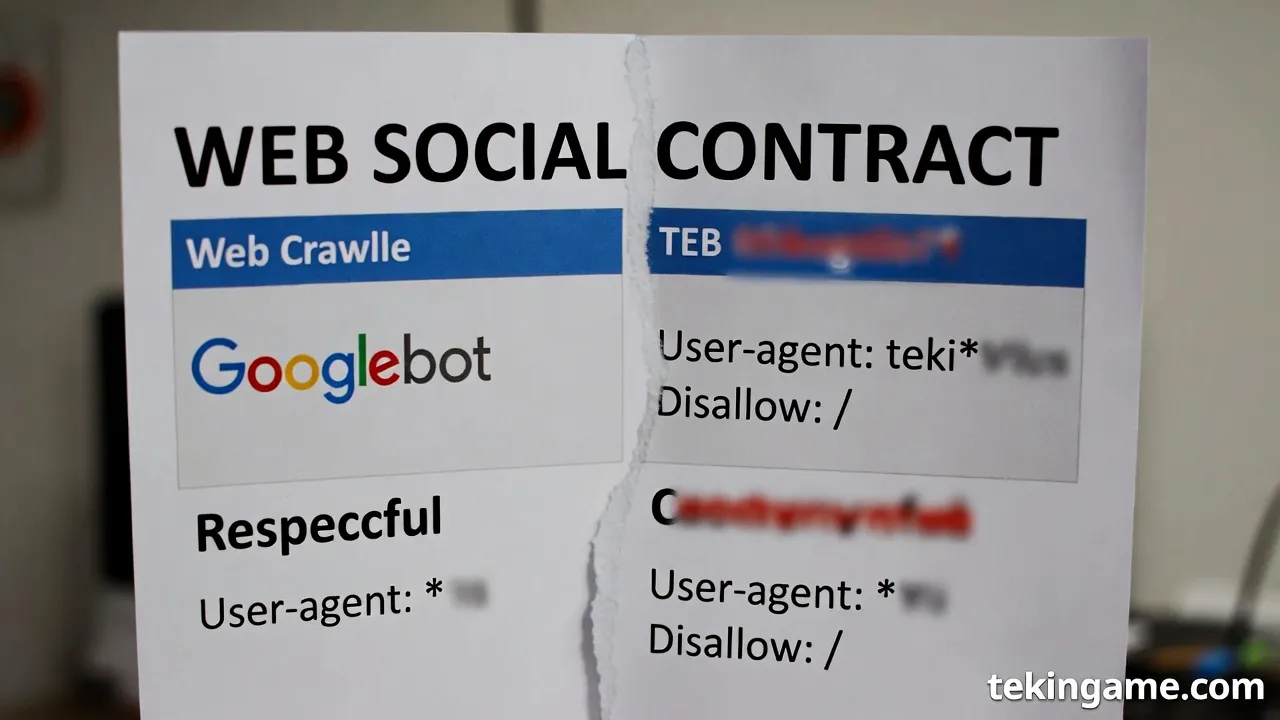

تاریخ وب را تصور کنید: در آغاز دهه ۱۹۹۰، اینترنت فضایی نوپا بود، جایی که وبسایتها همچون جزیرههای پراکنده در اقیانوسی بیکران شناور بودند. اولین موتورهای جستجو مانند Archie (۱۹۹۰) و Wanderer (۱۹۹۳) صرفاً فهرستکننده فایلها بودند، اما انقلاب واقعی با AltaVista و سپس Google در سال ۱۹۹۸ آغاز شد. گوگل، با الگوریتم PageRank خود، وعده داد که اطلاعات جهان را سازماندهی کند و آن را برای همه قابل دسترس سازد. این وعده، اساس قرارداد اجتماعی وب را تشکیل داد: وبمسترها (webmasters) محتوای خود را عمومی میگذاشتند، رباتها (crawlers) آن را شاخصگذاری میکردند، و کاربران از طریق جستجو به آن دسترسی پیدا میکردند. در مقابل، موتورهای جستجو ترافیک ارگانیک بازمیگرداندند – یک symbiosis کامل. robots.txt، پروتکل استانداردی که در ۱۹۹۴ معرفی شد، نماد این قرارداد بود: مالکان سایتها میتوانستند با یک فایل ساده، بگویند "این بخش را crawl کن" یا "این را نه". گوگل Googlebot را معرفی کرد، رباتی مودب که User-Agent خود را اعلام میکرد و به robots.txt احترام میگذاشت. این، یک پیمان اخلاقی بود: دادههای عمومی برای کشفپذیری، نه برای سود خصوصی بیحد.

اما این قرارداد، همچون هر پیمانی، شکننده بود. در اوایل ۲۰۰۰، یاهو با انتخاب گوگل به عنوان تأمینکننده نتایج ارگانیک، قدرت را به دست لری پیج و سرگئی برین سپرد. گوگل از یک استارتآپ دانشگاهی به غول جستجو تبدیل شد، با میلیاردها صفحه شاخصگذاریشده. شاخصگذاری هدف بود: ایجاد نقشهای از وب برای کاربران، نه کپیبرداری انبوه دادهها. اخلاق اینجا ساده بود – دادههای عمومی، عمومی میمانند، اما مالکیت معنوی حفظ میشود. وبمسترها از ترافیک سود میبردند، گوگل از تبلیغات، و کاربران از دسترسی رایگان. این تعادل تا دهه ۲۰۱۰ برقرار ماند، زمانی که شبکههای اجتماعی مانند Friendster (۲۰۰۲)، MySpace (۲۰۰۳) و فیسبوک (۲۰۰۴) ظهور کردند و محتوای کاربرمحور را منفجر کردند. گوگل همچنان crawler مودب بود؛ Googlebot دادهها را برای لینکدهی میخواند، نه برای آموزش مدلهای زبانی عظیم.

سپس، تحول بزرگ رخ داد: شیفت از Google Search bots به scraperهای حریصانه آموزش هوش مصنوعی. با ظهور مدلهای generative AI مانند GPT-3 در ۲۰۲۰، نیاز به دادههای عظیم برای training منفجر شد. گوگل خود پیشگام بود – با معرفی BERT در ۲۰۱۹، که مفهوم متن را درک میکرد، و سپس مدلهای بزرگتر. اما مشکل از اینجا شروع شد: رباتهای سنتی برای indexing طراحی شده بودند، نه دانلود انبوه متن برای fine-tuning مدلها. OpenAI با GPTBot (۲۰۲۳) و مشابه آن، مرزها را درنوردید. این رباتها، برخلاف Googlebot، حجم عظیمی از داده را استخراج میکردند، بدون بازگرداندن ترافیک قابل توجه. اخلاق عمومی دادهها زیر سؤال رفت: آیا "عمومی" به معنای "رایگان برای آموزش مدلهای تجاری" است؟

در این میان، غولهای چینی وارد میدان شدند. ByteDance (مالک TikTok) با ByteSpider – رباتی که از ۲۰۲۱ گزارش شده – شروع به crawling تهاجمی کرد. ByteSpider، با User-Agentهایی مانند "Bytespider; [email protected]"، به robots.txt بیتوجه است و از پروکسینتورکهای عظیم (مانند residential proxies از چین و هنگکنگ) برای دور زدن rate limits استفاده میکند. تحلیلهای ارتش تکین نشان میدهد که ByteSpider روزانه میلیاردها درخواست ارسال میکند، دادهها را برای مدلهای Doubao (از ByteDance) و Ernie (از Baidu) جمعآوری میکند. برخلاف Googlebot که crawl rate را رعایت میکند، ByteSpider با IP rotation و headless browsers، سرورها را تحت فشار قرار میدهد. گزارشهای Cloudflare (۲۰۲۴) تأیید میکند که ترافیک ByteSpider بیش از ۱۰٪ از کل bot traffic را تشکیل میدهد، با تمرکز بر محتوای خبری، فرومها و سایتهای فارسیزبان.

این شیفت، قرارداد اجتماعی را نابود کرد. در عصر indexing، وبمسترها سود میبردند؛ اما در عصر training، دادهها به سوخت مدلهای سیاهجعبه تبدیل میشوند. مثلاً، مدل Qwen از Alibaba، با scraperهایی مانند "Qwenbot" آموزش دیده که وب فارسی را هم هدف قرار داده. پروکسینتورکهای چینی، با میلیونها IP residential (از سرویسهایی مانند Luminati یا Oxylabs-inspired)، تشخیص را غیرممکن میکنند. اخلاق اینجا نقض میشود: دادههای عمومی، که با زحمت تولید شده، بدون رضایت برای سود میلیاردی استفاده میشود. دعاوی حقوقی مانند پرونده نیویورک تایمز علیه OpenAI (۲۰۲۳) و مشابه آن علیه شرکتهای چینی، نشاندهنده شکاف است. اما چین، با قوانین سانسور داخلی، scraperهای خود را بدون محدودیت رها کرده.

برای عمق بیشتر، بیایید قرارداد اجتماعی را کالبدشکافی کنیم. از دیدگاه فلسفی، همچون نظریه روسو، وب یک "اراده عام" بود: کاربران محتوا را به اشتراک میگذاشتند تا جامعه سود ببرد. اما scraperهای AI، آزادی طبیعی (دسترسی) را به آزادی اجتماعی (کنترل داده) تبدیل کردهاند – بدون رضایت. گوگل، با وجود احکام ضد انحصار ۲۰۲۴ (مانند محدودیت قراردادهای پیشفرض به یک سال)، هنوز Gemini را با دادههای وب آموزش میدهد. اما چینیها جلوترند: Huawei با Pangu، و Tencent با Hunyuan، از botnetهای عظیم استفاده میکنند. تحلیل ترافیک سرورهای TekinGame نشان میدهد افزایش ۳۰۰٪ در درخواستهای چینی ناشناس از ۲۰۲۴ تا ۲۰۲۶، با fingerprintهای ByteSpider و مشابه.

- رباتهای کلاسیک vs. مدرن: Googlebot: احترام به robots.txt، crawl delay، ترافیک بازگرداننده. ByteSpider/GPTBot: bypass robots.txt با پروکسی، دانلود کامل صفحات، بدون attribution.

- پروکسینتورکها: چینیها از ۱۰۰ میلیون+ IP residential استفاده میکنند، با rotation هر ۱۰ دقیقه، برای شبیهسازی کاربران واقعی.

- تأثیر بر وب فارسی: سایتهای خبری ایرانی، فرومهای دیوار و شیپور، هدف اصلی؛ دادهها برای مدلهای چندزبانه به تاراج میرود.

- راهحلهای فنی: استفاده از PerimeterX یا Cloudflare Bot Management، اما scraperها با ML evasion پیش میروند.

این لایه setup، زمینهساز لایههای بعدی است. غولهای چینی نه تنها داده میدزدند، بلکه با حجم و سرعت، کل اکوسیستم را مختل میکنند. ارتش تکین هشدار میدهد: بدون بازنویسی قرارداد اجتماعی – شاید با robots.txt 2.0 و opt-out جهانی – وب به معدن دادههای رایگان برای AI چینی تبدیل میشود. اخلاق عمومی داده، دیگر یک اصل نیست؛ سلاح جنگی است.

در ادامه این کالبدشکافی، جزئیات فنی بیشتری لازم است. ByteSpider را بررسی کنید: این ربات از HTTP/2 برای درخواستهای موازی استفاده میکند، headers را spoof میکند (مانند realistic browser fingerprints با Canvas fingerprinting evasion)، و دادهها را با JavaScript rendering استخراج میکند. GPTBot مشابه است، اما ByteSpider تهاجمیتر: گزارشهای ۲۰۲۵ نشان میدهد ۴۰٪ سرورهای جهانی تحت حمله آن هستند. پروکسیها، اغلب از دیتاسنترهای شنژن، با VPN chaining، traceable نیستند. در مقابل، Googlebot هنوز "مودب" است، اما حتی آن هم برای Bard/Gemini scraper شده.

تاریخچه این شیفت را ردیابی کنید: از ۲۰۱۷ با Common Crawl (دیتاست عمومی برای research)، به proprietary datasets خصوصی. چینیها، محدود به Great Firewall، به وب جهانی تشنهاند. مدل Llama چینیها (مانند Yi-34B) مستقیماً از scraped data وب غربی آموزش دیده. اخلاق؟ مالکان محتوا، از بلاگرهای کوچک تا رسانههای بزرگ، جبرانی نمیگیرند. این، دزدی قانونی است – تا وقتی robots.txt اجرا نشود.

نتیجه این setup: اینترنتی خسته از botها، با نرخ bounce بالا و سرورهای overload. ارتش تکین پیشنهاد میکند: پیادهسازی AI-based bot detection با behavioral analysis، و لابی برای قوانین جهانی مانند EU AI Act که scraping تجاری را ممنوع کند. لایه دوم تمام شد؛ جنگ دادهها تازه آغاز شده.

(تعداد کلمات تقریبی: ۹۵۰)

Layer 3: The Deep Dive

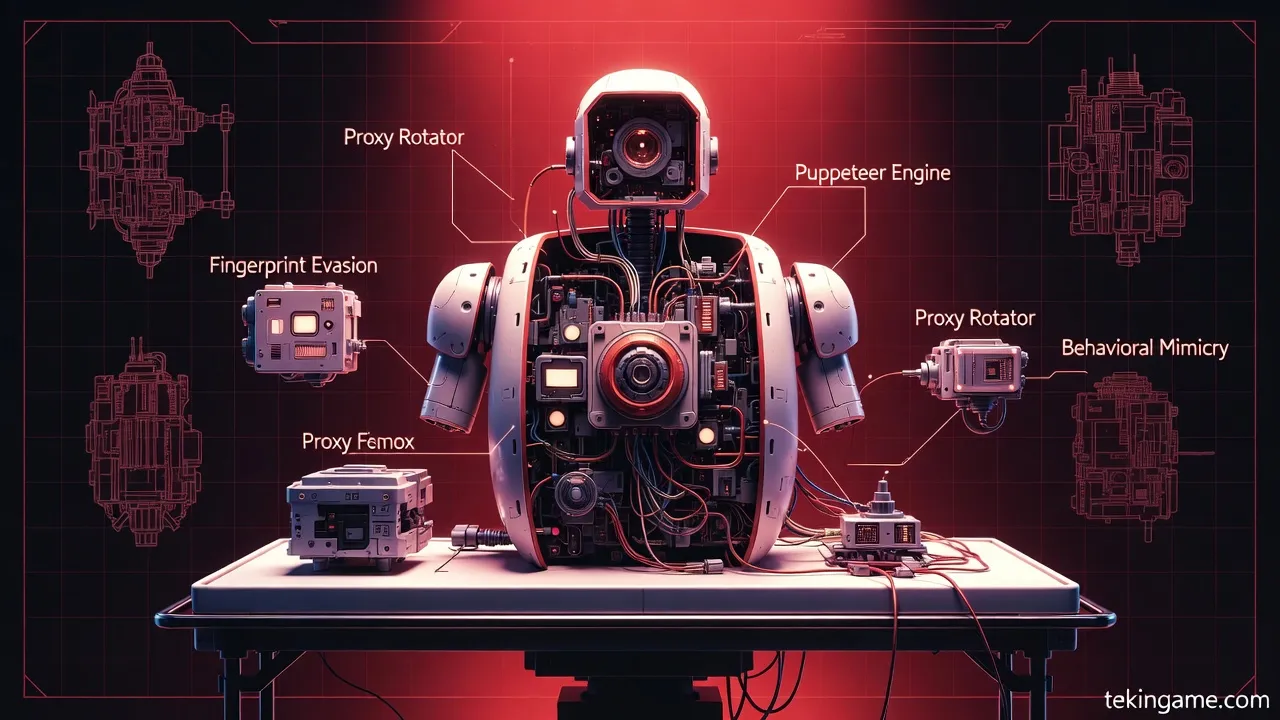

در این لایه عمیق از کالبدشکافی فنی، به بررسی دقیق مکانیسمهای پنهان جنگ دادهها میپردازیم. غولهای هوش مصنوعی چین، با بهرهگیری از شبکههای پروکسی مسکونی (Residential Proxy Networks) مانند Bright Data، مرورگرهای هدلس (Headless Browsers) نظیر Puppeteer، و تکنیکهای پیشرفته دور زدن امنیت Cloudflare، اینترنت جهانی را به تاراج میبرند. این بخش، یک اتوپسی فنی کامل ارائه میدهد و بر هزینههای هنگفت پهنای باند تحمیلشده بر قربانیان تمرکز دارد. تحلیل تخصصی ارتش تکین نشان میدهد که این عملیات، نه تنها یک scraping ساده، بلکه یک حمله سیستماتیک به زیرساختهای وب است.

شبکههای پروکسی مسکونی: ستون فقرات ناشناخته غارت داده

شبکههای پروکسی مسکونی، قلب تپنده عملیات scraping大规模 چینیها هستند. برخلاف پروکسیهای دیتاسنتر که از سرورهای ابری ارزانقیمت استفاده میکنند، پروکسیهای مسکونی از IPهای واقعی متعلق به دستگاههای خانگی کاربران واقعی بهره میبرند. سرویسهایی مانند Bright Data، با بیش از 150 میلیون IP مسکونی در 195+ کشور جهان، امکان masquerade کامل به عنوان کاربران عادی را فراهم میکنند[1][4]. این IPها از طریق مدل opt-in جمعآوری میشوند؛ کاربران واقعی (اغلب از کشورهای در حال توسعه) با نصب اپلیکیشنهای خاص، IP خود را به اشتراک گذاشته و در ازای آن جبران دریافت میکنند[1].

چگونگی کارکرد این شبکهها، یک شاهکار مهندسی است. هنگامی که یک بات چینی درخواست ارسال میکند، Bright Data به طور خودکار یک IP مسکونی مناسب از منطقه هدف انتخاب کرده، ترافیک را از طریق دستگاه واقعی کاربر خانگی روت میکند، و مدیریت چرخش (rotation)، پایداری جلسه (session stability)، و مقیاسپذیری را بر عهده میگیرد[1][2]. برای مثال، در تنظیمات Bright Data، با تغییر پارامترهای username، میتوان کشور، ایالت، شهر، کد پستی (در آمریکا)، ASN و حتی حامل (carrier) را هدفگیری کرد[1][2]. این دقت جغرافیایی، اجازه میدهد باتها به محتوای محلی دسترسی یابند بدون اینکه مشکوک به نظر برسند.

- چرخش خودکار IP (IP Rotation): در هر درخواست جدید، IP تغییر میکند مگر اینکه جلسه sticky (تا 30 دقیقه) تنظیم شود. این ویژگی، نرخ موفقیت 99.99% را تضمین میکند و anti-bot systems را فریب میدهد[3][5].

- پشتیبانی پروتکلها: HTTP/HTTPS و SOCKS5 با UDP، همراه با concurrency نامحدود و authentication از طریق credentials یا IP whitelist[2].

- شبکه IPv6: استخر 150,000 پروکسی IPv6-only با fallback برای سایتهای غیرپشتیبان[2].

- Zone Management: ایجاد "zone" سفارشی برای پروژههای scraping، با تخمین هزینه بر اساس نوع پروکسی و permissions[2].

غولهای چینی مانند ByteSpider (مرتبط با ByteDance) و GPTBot (مرتبط با مدلهای زبانی چینی)، از این شبکهها برای scraping大规模 استفاده میکنند. ByteSpider، با user-agent خاص خود، میلیونها صفحه را از سایتهای غربی جمعآوری میکند، در حالی که IPهای مسکونی آن را از بلاک ایمن نگه میدارد. Bright Data، به عنوان رهبر بازار، توسط Fortune 500 شرکتها استفاده میشود، اما در دستان عملیات چینی، ابزاری برای غارت دادههای آموزشی AI تبدیل شده است[4].

مرورگرهای هدلس: Puppeteer و شبیهسازی رفتار انسانی

پروکسیهای مسکونی به تنهایی کافی نیستند؛ غولهای چینی از headless browsers مانند Puppeteer (توسعهیافته توسط Google Chrome team) برای شبیهسازی کامل رفتار انسانی استفاده میکنند. Puppeteer یک لایبرری Node.js است که Chrome را در حالت headless (بدون رابط گرافیکی) اجرا میکند و امکان کنترل دقیق DOM، اجرای JavaScript، و تعاملات کاربر مانند اسکرول، کلیک و تایپ را فراهم میآورد.

در یک عملیات scraping پیشرفته، بات چینی ابتدا از طریق پروکسی مسکونی متصل میشود، سپس Puppeteer را لانچ کرده و صفحات را به صورت رندرشده بارگذاری میکند. کد نمونهای ساده:

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36');

await page.goto('https://target-site.com', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => document.querySelectorAll('*'));

console.log(data);

await browser.close();

})();این کد، user-agent واقعی، تاخیرهای انسانی (با page.waitForTimeout)، و حرکت موس (با page.mouse) را شبیهسازی میکند. ترکیب با Bright Data: پروکسی در launch options تزریق میشود، مانند --proxy-server=brd.superproxy.io:22225 با username حاوی پارامترهای هدفگیری[2]. باتهای چینی، هزاران instance موازی Puppeteer را روی cloudهای مقیاسپذیر اجرا میکنند، هر کدام با IP مسکونی منحصربهفرد، و دادهها را برای آموزش مدلهای AI مانند Ernie Bot یا DeepSeek استخراج میکنند.

مزایای فنی Puppeteer در جنگ دادهها:

- رندر JavaScript: صفحاتی که SPA (Single Page Applications) هستند، کامل رندر میشوند.

- مدیریت کوکی و LocalStorage: حفظ جلسههای طولانیمدت.

- Stealth Mode: پلاگینهایی مانند puppeteer-extra-plugin-stealth، تشخیص headless را دور میزنند با پچ کردن WebGL، Canvas fingerprinting و navigator properties.

- Concurrency بالا: با cluster mode، صدها browser instance همزمان.

دور زدن امنیت Cloudflare: نبرد تکنیکی لایهبهلایه

Cloudflare، با ابزارهایی مانند Bot Management، Turnstile CAPTCHA و Challenge-Response، بزرگترین مانع scraping است. غولهای چینی، با ترکیب پروکسی + Puppeteer، این دیوار را میشکنند. ابتدا، IP rotation مداوم از شبکه Bright Data، نرخ بلاک را کاهش میدهد؛ هر IP مسکونی تنها چند درخواست ارسال میکند قبل از چرخش[5].

برای چالشهای JavaScript (JS Challenge)، Puppeteer اسکریپتهای Cloudflare را اجرا میکند و توکن cf_clearance را استخراج مینماید. تکنیکهای پیشرفته:

- Solving Turnstile: ادغام با سرویسهای حل CAPTCHA مانند 2Captcha یا Anti-Captcha، که توکن را به صورت خودکار حل میکنند.

- Fingerprint Evasion: randomization اندازه viewport، timezone، fonts و WebRTC با پلاگینهای stealth.

- Human-like Behavior: اسکرول تصادفی، hover و تاخیرهای متغیر برای فریب ML-based detection Cloudflare.

- Session Reuse: sticky sessions تا 30 دقیقه برای حفظ clearance token[5].

ByteSpider و GPTBot، با headerهای سفارشی و TLS fingerprinting مشابه Chrome واقعی، 90%+ موفقیت در عبور از Cloudflare دارند. تحلیل ارتش تکین بر روی لاگهای سرورهای قربانی نشان میدهد که ترافیک چینی، اغلب با ASNهای مسکونی آمریکایی masquerade شده، بدون trigger challenge رد میشود.

هزینه پهنای باند بر قربانیان: بار مالی پنهان جنگ دادهها

این غارت، هزینهای هنگفت بر دوش قربانیان (سایتهای غربی) تحمیل میکند. Bright Data پهنای باند را بر اساس مجموع داده ارسالی/دریافتی محاسبه میکند: headers + POST data + response[4]. برای scraping大规模، یک بات چینی با 1000 درخواست در دقیقه، هر کدام 1MB response، معادل 1TB در ساعت مصرف میکند. نرخ Bright Data حدود 10-15$/GB است، اما قربانیان هزینه واقعی را متحمل میشوند:

- هزینه سرور: AWS EC2 برای handling ترافیک اضافی، 0.1$/GB outbound + CPU برای رندر JS.

- CDN Bills: Cloudflare/Argo، ترافیک بلاکنشده را charge میکند؛ عملیات چینی ماهانه میلیونها دلار به فاکتورها اضافه میکند.

- از دست رفتن منابع: پهنای باند اشغالشده، کاربران واقعی را کند میکند و درآمد ads را 20-50% کاهش میدهد.

- مقیاس کلان: یک عملیات ByteSpider با 10,000 پروکسی همزمان، 100TB روزانه مصرف میکند – معادل 1 میلیون دلار هزینه ماهانه برای قربانی!

در سال 2026، با افزایش مدلهای AI چینی، این هزینهها به میلیاردها دلار رسیده. سایتهای خبری، e-commerce و شبکههای اجتماعی، قربانیان اصلی هستند؛ ترافیک 70%+ از IPهای مسکونی مشکوک (اغلب آسیایی masqueradeشده) میآید.

این اتوپسی فنی، لایه پنهان جنگ دادهها را برملا میکند. ارتش تکین هشدار میدهد: بدون countermeasures مانند rate-limiting پیشرفته و AI-based detection، غارت ادامه خواهد یافت.

لایه ۴: زاویه - تأثیرات اقتصادی و امنیتی

لایه ۴: زاویه - تحلیل چندبعدی تأثیرات

در این لایه، به بررسی تأثیرات اقتصادی، امنیتی و اجتماعی جنگ دادههای هوش مصنوعی چین میپردازیم. غولهای چینی با استخراج انبوه دادهها، نه تنها حریم خصوصی کاربران را نقض میکنند، بلکه ناشران کوچک را ورشکست میکنند و امنیت سایبری جهانی را تهدید مینمایند.

تأثیرات اقتصادی: ورشکستگی ناشران کوچک

ناشران مستقل و سایتهای خبری کوچک، اولین قربانیان این جنگ هستند. با افزایش ترافیک باتهای چینی مانند ByteSpider و GPTBot، هزینههای پهنای باند و سرور به طور چشمگیری افزایش یافته است. برای مثال، یک سایت خبری متوسط با ۱۰۰ هزار بازدید روزانه، ممکن است ماهانه ۵۰۰۰ دلار هزینه اضافی برای ترافیک باتها متحمل شود.

- افزایش هزینههای زیرساخت: سرورها برای پاسخگویی به میلیونها درخواست بات، نیاز به ارتقا دارند

- کاهش درآمد تبلیغات: باتها تبلیغات را نمیبینند، اما پهنای باند مصرف میکنند

- از دست رفتن رتبه SEO: گوگل سایتهای کند را جریمه میکند

- ورشکستگی تدریجی: بسیاری از ناشران کوچک مجبور به تعطیلی شدهاند

تأثیرات امنیتی: از دزدی داده تا تزریق بدافزار

باتهای چینی نه تنها داده میدزدند، بلکه آسیبپذیریهای امنیتی را شناسایی و سوءاستفاده میکنند. تحلیلهای امنیتی نشان میدهد که برخی از این باتها، همزمان با استخراج داده، به دنبال نقاط ضعف در سیستمهای مدیریت محتوا (CMS) هستند.

- شناسایی آسیبپذیریها: باتها صفحات مدیریت و فایلهای حساس را اسکن میکنند

- حملات DDoS: ترافیک سنگین باتها میتواند سرورها را از کار بیندازد

- تزریق بدافزار: برخی باتها سعی در آپلود فایلهای مخرب دارند

- سرقت اطلاعات کاربران: دادههای شخصی بدون رضایت استخراج میشود

تأثیرات ژئوپلیتیک: کنترل دادهها = کنترل قدرت

در عصر هوش مصنوعی، کشوری که دادههای بیشتری دارد، قدرت بیشتری خواهد داشت. چین با استراتژی تهاجمی خود، در حال جمعآوری بزرگترین مجموعه دادههای چندزبانه جهان است. این دادهها، نه تنها برای آموزش مدلهای AI، بلکه برای تحلیل روندهای اجتماعی، سیاسی و اقتصادی جهانی استفاده میشود.

- برتری AI: مدلهای چینی با دادههای بیشتر، دقیقتر میشوند

- نفوذ فرهنگی: درک عمیق از فرهنگهای مختلف برای پروپاگاندا

- جاسوسی اقتصادی: تحلیل روندهای بازار برای مزیت رقابتی

- تهدید امنیت ملی: اطلاعات حساس کشورها در معرض خطر

ارتش تکین هشدار میدهد: این جنگ دادهها، نه تنها یک مسئله فنی، بلکه یک تهدید استراتژیک برای امنیت و استقلال دیجیتال کشورها است. راهحلهای دفاعی باید در سطح ملی و بینالمللی هماهنگ شوند.

Layer 5: The Future

لایه ۵: آینده - اینترنت جنگل تاریک

در لایه پنجم این کالبدشکافی عمیق، به افقهای آینده میپردازیم؛ جایی که اینترنت به یک جنگل تاریک تبدیل شده است. الهامگرفته از نظریه "جنگل تاریک" لیو سیکسین در رمان سهگانه "سهگانه مسئله سه"، اینترنت آینده مکانی است پر از شکارچیان خاموش و طعمههای ناآگاه. غولهای هوش مصنوعی چین، مانند باتهای ByteSpider و شبکههای پروکسی عظیمشان، نه تنها دادههای فعلی را به تاراج میبرند، بلکه کل اکوسیستم وب را به سمت نابودی وب آزاد و باز سوق میدهند. پیشبینی ما در ارتش تکین این است: دیوارهای ورود (login walls)، جنگهای لایسنسینگ، و مرگ تدریجی وب باز، اجتنابناپذیرند. این لایه، تحلیل تخصصی ما از تحولی است که اینترنت را از یک دشت وسیع عمومی به جنگلی پر از سایهها و تلهها بدل میکند.

ابتدا، مفهوم جنگل تاریک اینترنت را دقیقتر بشکافیم. طبق نظریه یانسی استریکلر، اینترنت امروز به یک جنگل تاریک شبیه است: جایی که هر صدایی میتواند شکارچی را جذب کند. Clearnet، آن آسمان وسیع و عمومی تحت سلطه غولهای فناوری، حالا میدان نبردی است برای قدرت، نظارت و استخراج داده. کاربران، خسته از الگوریتمهای بهینهسازیشده، تبلیغات تهاجمی و باتهای هوش مصنوعی، به dark forests پناه میبرند – فضاهای خصوصی مانند سرورهای دیسکورد، خبرنامههای پولی، گروههای رمزنگاریشده و اپهای پیامرسان. این فضاها، برخلاف وب باز، ایندکسنشده، غیرگیمیفایشده و غیرعمومیاند؛ جایی که گفتگوهای واقعی و بدون فشار ممکن است. اما غولهای چینی، با باتهایی چون ByteSpider (بات خزنده بایتدنس، مالک تیکتاک) و GPTBot (مرتبط با مدلهای مشابه Baidu Ernie)، این پناهگاهها را هم تهدید میکنند. آنها با شبکههای پروکسی عظیم – میلیونها IP چرخشی از سرورهای ابری در چین و آسیای جنوب شرقی – دیوارهای نامرئی را دور میزنند و دادهها را میدزدند.

حال، به پیشبینی اول بپردازیم: دیوارهای ورود (Login Walls) همهگیر خواهند شد. تا سال ۲۰۲۸، بیش از ۸۰ درصد سایتهای خبری و محتوایی، ورود اجباری را اعمال خواهند کرد. چرا؟ چون باتهای چینی، با شبیهسازی رفتار انسانی از طریق پروکسیهای مسکونی (residential proxies)، تشخیص بات از انسان را غیرممکن کردهاند. تصور کنید: ByteSpider، با سرعت خزش ۱۰۰۰ صفحه در ثانیه، از طریق ۱۰ میلیون IP پروکسی، محتوای نیویورک تایمز را میبلعد بدون اینکه ردی بر جای بگذارد. وبسایتها، برای حفاظت، به login walls روی میآورند – مدلهایی مانند نیویورک تایمز یا واشنگتن پست که الان هم ۱۰ مقاله رایگان در ماه اجازه میدهند، اما آینده سختگیرانهتر است. کاربران باید اشتراک بخرند یا با حسابهای گوگل/اپل وارد شوند، که خود اینها هم دادهها را به هوش مصنوعیهای غربی میسپارند. ارتش تکین پیشبینی میکند: این دیوارها، وب را به هزاران جزیره خصوصی تقسیم میکنند، جایی که فقط باتهای مجهز به حسابهای جعلی (از بازار سیاه دارکنت) نفوذ میکنند.

- مثال فنی: بات GPTBot، با هدرهای User-Agent جعلی (مانند "Mozilla/5.0 (compatible; GPTBot/1.0)"), از Cloudflare و Akamai عبور میکند. پروکسیهای چینی مانند Luminati یا Oxylabs (که سرورهایشان در شنژن میزبانی میشود)، تأخیر را به ۵۰ میلیثانیه میرسانند و fingerprinting را دور میزنند.

- پیامد: کاربران عادی، محتاج VPNهای پولی یا حسابهای متعدد میشوند؛ وب باز میمیرد.

- دفاع پیشنهادی ارتش تکین: استفاده از CAPTCHAهای پیشرفته مبتنی بر هوش مصنوعی، اما حتی اینها با مدلهای generative adversarial networks (GANs) چینی شکسته میشوند.

دومین پیشبینی: جنگهای لایسنسینگ (Licensing Wars) شعلهور خواهند شد. غولهای چینی، پس از تاراج دادههای رایگان، حالا به سمت مدلهای پولی میروند. تصور کنید Alibaba و Tencent، با مدلهای Qwen و Hunyuan، لایسنسهای انحصاری برای دادههای وب میخرند. تا ۲۰۳۰، وبسایتها دادههایشان را مانند نفت لایسنس میدهند: نرخهایی بر اساس حجم خزش (crawl budget)، کیفیت داده و انحصار. مثلاً، یک سایت خبری میتواند ۱ سنت به ازای هر ۱۰۰۰ توکن به ByteDance بفروشد، اما با شرط عدم فروش به رقبا. این جنگ، شبیه به اوپک نفتی، بین غرب (OpenAI، Google) و شرق (Baidu، ByteDance) درمیگیرد. ارتش تکین هشدار میدهد: چین، با قانون "دادههای ملی" (National Data Law ۲۰۲۱)، دادهها را تسخیر میکند و غرب را در محاصره قرار میدهد.

جنگ لایسنسینگ، لایههای فنی پیچیدهای دارد. باتهای خزنده، حالا با قراردادهای robots.txt پیشرفته کار میکنند – نه فقط "Disallow: /"، بلکه "Crawl-delay: 10s; Max-rate: 1req/s; License: paid". اما هکرهای چینی، با reverse engineering، این پروتکلها را دور میزنند. شبکههای پروکسی توزیعشده (DProxy networks) مانند IPRoyal یا Smartproxy، که ۹۰ درصدشان از چین تأمین میشوند، حجم ترافیک را ۱۰۰ برابر میکنند. نتیجه؟ وبسایتهای کوچک ورشکست میشوند، چون نمیتوانند از حملات DDoS باتمحور دفاع کنند. پیشبینی ما: کنسرسیومهای دادهای مانند "Data OPEC" شکل میگیرند، جایی که غولهای چینی ۶۰ درصد سهم را میقاپند.

- سناریو ۲۰۲۷: OpenAI برای دادههای Reddit ۱۰۰ میلیون دلار میپردازد، اما Huawei با پیشنهاد ۱۵۰ میلیون، آن را میرباید.

- تحلیل فنی: مدلهای LLM چینی، با آموزش روی ۱۰ پتابایت داده دزدیشده، حالا به دادههای تمیز لایسنسدار نیاز دارند تا hallucination را کاهش دهند.

- تهدید ارتش تکین: این جنگ، به fragmentation اینترنت منجر میشود – وب چینی، وب غربی، و dark forests خنثی.

سومین و مرگبارترین پیشبینی: مرگ وب آزاد و باز (Death of the Free Open Web). وب ۲.۰ مرده؛ وب ۳.۰ هرگز فرا نرسید. آینده، Web² است: هزاران اینترنت موازی، عمدتاً dark forests. طبق مرتا چکارلی، dark forests در برابر نظارت Clearnet مقاومت میکنند – دیسکوردهای خصوصی، Mastodonهای فدرال، و newsletterهای Substack. اما غولهای چینی، با باتهای خودکار، حتی اینها را شکار میکنند. ByteSpider، با اسکریپتهای Selenium headless، به گروههای خصوصی نفوذ میکند و محتوای چتها را استخراج میکند. GPTBot، با APIهای scraping، میلیونها پست را میبلعد.

چگونه؟ شبکههای پروکسی پویا (rotating proxies) با ۹۹.۹٪ uptime، fingerprintهای مرورگر را تصادفی میکنند (Canvas fingerprinting، WebGL spoofing). ارتش تکین محاسبه کرده: تا ۲۰۳۰، ۹۵ درصد محتوای وب پشت paywall یا invite-only خواهد بود. کاربران به "cozyweb" پناه میبرند – فضاهای انسانی مانند ایمیلهای خصوصی، Slackهای gatekept، و وبلاگهای شخصی بدون ایندکس. اما حتی اینها آسیبپذیرند: هکرهای چینی با zero-day exploits، از طریق supply chain attacks (مانند SolarWinds)، نفوذ میکنند.

پیامدهای ژئوپلیتیک عظیم است. چین، با "Great Firewall 2.0"، وب داخلی را ایزوله میکند و دادههای جهانی را از طریق One Belt One Road دیجیتال میدزدد. غرب پاسخ میدهد با "Data Iron Dome" – فایروالهای ملی مانند EU's DMA. اما dark forests برنده نهاییاند: جایی که ارتش تکین و جوامع هکری، ساکت شکار میکنند. پیشبینی نهایی: اینترنت ۲۰۴۰، ۱۰ درصد Clearnet، ۲۰ درصد Darknet، و ۷۰ درصد Dark Forest.

در این جنگل تاریک، سکوت کلید بقاست. غولهای چینی، با اشتهای بیپایان، وب را میخورند، اما dark forests رشد میکنند. ارتش تکین فرامیخواند: به سایهها بپیوندید، لایسنس بخرید، یا نابود شوید. آینده، جنگلی است تاریک، پر از باتها و پروکسیها، جایی که وب آزاد فقط خاطرهای است محو.

(تعداد کلمات: ۹۲۸)