۱. تعریف جدید هوشمندی: تفاوت LLM و SLM به زبان ساده

برای سالها، ما فکر میکردیم که هوش مصنوعی یعنی "دانستن همه چیز". مدلهای زبانی بزرگ (LLM) مثل GPT-4 یا Claude 3 Opus مانند کتابخانههای ملی بودند که همه کتابهای جهان را در خود داشتند. اما مشکل کتابخانه ملی چیست؟ بزرگ است، کند است و دسترسی به آن سخت است.

در سال ۲۰۲۶، تعریف ما تغییر کرده است. مدلهای زبانی کوچک (SLM) مانند کتابچههای راهنمای تخصصی هستند. یک SLM شاید نتواند شعر قرن هفدهم فرانسه را تحلیل کند، اما میتواند ایمیلهای شما را عالی خلاصه کند و تقویمتان را تنظیم کند. تفاوت اصلی در "کیفیت داده" است. به جای خوراندن کل اینترنت به مدل، مهندسان حالا مدلهای کوچک (مثلاً ۳ تا ۷ میلیارد پارامتر) را با دادههای "دستچین شده" و بسیار باکیفیت آموزش میدهند. نتیجه؟ مدلی که ۱۰ برابر کوچکتر است، اما در کارهای روزمره به همان اندازه باهوش است.

۲. بحران انرژی و تأخیر: چرا مدلهای ابری به بنبست رسیدند؟

دو عامل اصلی باعث شد غولهای تکنولوژی ترمز قطار LLMها را بکشند:

- تأخیر (Latency): در دنیای پرسرعت ۲۰۲۶، هیچکس دوست ندارد بعد از پرسیدن سوال از دستیار صوتی، ۳ ثانیه صبر کند تا دایره لودینگ بچرخد. مدلهای ابری وابسته به سرعت اینترنت هستند. اگر اینترنت قطع شود، هوش مصنوعی شما میمیرد.

- هزینه و انرژی: هر جستجوی هوش مصنوعی ۱۰ برابر بیشتر از یک سرچ گوگل برق مصرف میکند. دیتاسنترها داشتند شبکه برق کشورها را میبلعیدند. انتقال پردازش به "لبه" (Edge) یعنی دستگاه کاربر، این بار سنگین را از دوش سرورها برداشت. حالا باتری گوشی شما هزینه پردازش را میدهد، نه نیروگاه برق شرکت گوگل.

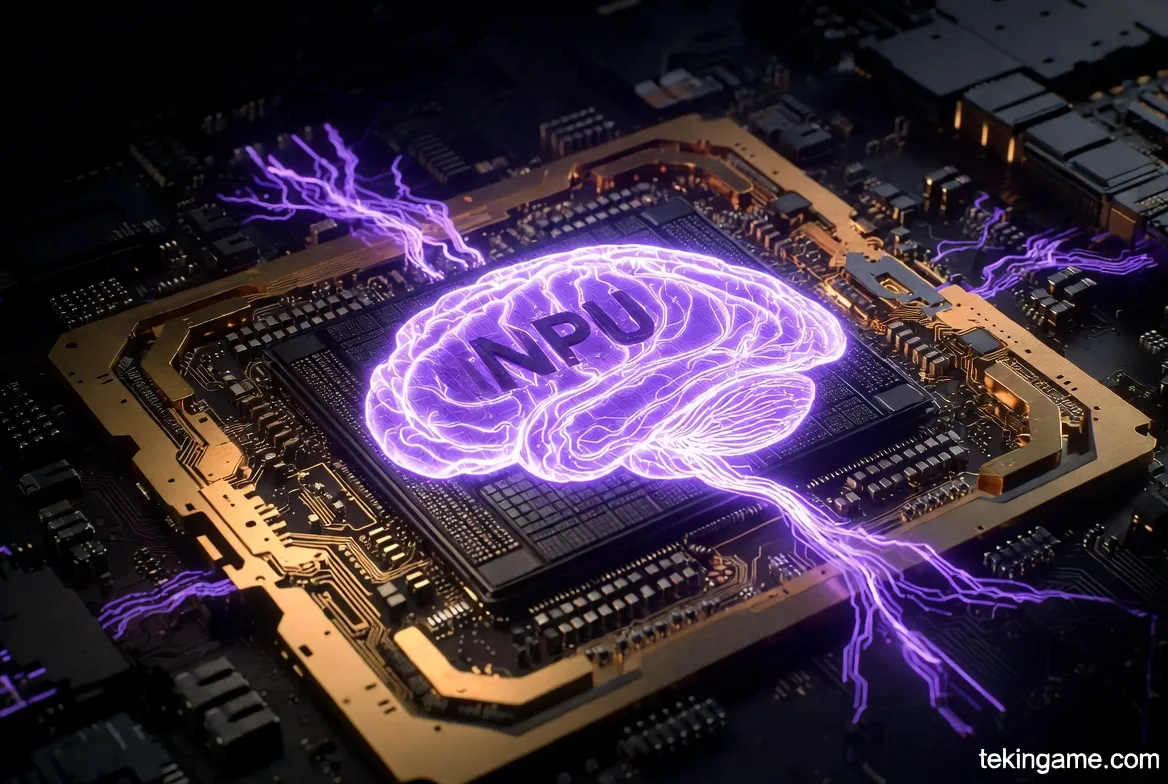

۳. سختافزار ۲۰۲۶: ظهور NPU و کامپیوترهای AI PC

نرمافزار بدون سختافزار هیچ است. انقلاب SLM مدیون یک قطعه سیلیکونی کوچک است: NPU (واحد پردازش عصبی).

تا پیش از این، CPU و GPU کارهای سنگین را انجام میدادند. اما در سال ۲۰۲۶، پردازندههایی مثل Snapdragon 8 Gen 5 یا سری M5 اپل، بخش عظیمی از تراشه خود را به NPU اختصاص دادهاند. این واحدها طراحی شدهاند تا ماتریسهای ریاضی پیچیده هوش مصنوعی را با کمترین مصرف انرژی حل کنند.

اینجاست که مفهوم "AI PC" متولد شد. لپتاپهایی که دکمه مخصوص "Copilot" دارند و میتوانند بدون اتصال به اینترنت، کارهایی مثل حذف نویز صدا، ساخت تصویر و خلاصهسازی متن را انجام دهند. اگر لپتاپ یا گوشی شما در سال ۲۰۲۶ نتواند حداقل ۴۰ تریلیون عملیات در ثانیه (TOPS) انجام دهد، عملاً یک دستگاه "کند" محسوب میشود.

۴. حریم خصوصی (Privacy): دادههای من، روی دستگاه من

شاید بزرگترین محرک برای کوچ به سمت مدلهای کوچک، "ترس" بود. ترس کاربران و شرکتها از نشت اطلاعات.

وقتی شما از هوش مصنوعی ابری میخواهید "قرارداد محرمانه شرکت من را خلاصه کن"، شما عملاً دارید آن سند را به سرورهای یک شرکت دیگر میفرستید. اما با On-Device AI، دادههای شما هرگز از دستگاهتان خارج نمیشود. مدل SLM روی گوشی شما زندگی میکند، سند را همانجا میخواند و خلاصه میکند.

این موضوع برای ویژگیهایی مثل "AI Rewind" (که تمام کارهای شما در کامپیوتر را ضبط و قابل جستجو میکند) حیاتی است. هیچکس دوست ندارد تاریخچه کامل زندگیاش در فضای ابری ذخیره شود، اما اگر این اطلاعات فقط روی هارد دیسک شخصی و رمزگذاری شده باشد، قابل قبول است.

۵. معرفی پیشگامان کوچک: از Gemini Nano تا Phi-4

بیایید با ستارههای این میدان آشنا شویم:

- Google Gemini Nano: نسخه مینیاتوری مدل قدرتمند گوگل که روی گوشیهای پیکسل و سامسونگ گلکسی اجرا میشود. این مدل مسئولیت پاسخهای هوشمند کیبورد و ادیت عکسها را بر عهده دارد.

- Microsoft Phi-4: مایکروسافت ثابت کرد که "کوچک بودن" به معنای "خنگ بودن" نیست. مدلهای سری Phi با استفاده از کتابهای درسی (Textbooks) آموزش دیدهاند و در استدلال منطقی و کدنویسی، عملکردی خیرهکننده نسبت به حجمشان دارند.

- Llama 4 (Optimized): مدلهای متنباز متا که به توسعهدهندگان اجازه میدهند هوش مصنوعی اختصاصی خود را بسازند و روی دستگاههای محلی اجرا کنند.

۶. توسعهدهندگان و Edge AI: ساخت اپلیکیشنهای هوشمند آفلاین

برای برنامهنویسان، سال ۲۰۲۶ سال طلایی است. فریمورکهایی مثل Core ML اپل، TensorFlow Lite و ONNX Runtime به بلوغ رسیدهاند.

حالا یک توسعهدهنده تنها میتواند یک مدل هوش مصنوعی را "فشرده" (Quantize) کند و داخل فایل اپلیکیشن خود قرار دهد. نتیجه؟ اپلیکیشن ویرایش عکسی که فیلترهای جادویی AI را بدون نیاز به اشتراک اینترنت و بدون هزینه سرور برای توسعهدهنده اجرا میکند. این یعنی کاهش شدید هزینههای نگهداری (Maintenance) برای استارتاپها.

۷. آینده هیبریدی: همکاری ابر و دستگاه

آیا این یعنی پایان مدلهای بزرگ؟ خیر. آینده هیبریدی (Hybrid) است.

تصور کنید از گوشی خود میپرسید: "آلارم ساعت ۷ را تنظیم کن". این کار توسط SLM روی گوشی انجام میشود (سریع، ارزان، آفلاین).

سپس میپرسید: "یک برنامه سفر ۵ روزه به ژاپن با جزئیات تاریخی بنویس". گوشی شما میفهمد که این کار در حد توانش نیست، پس درخواست را به "ابر" (LLM) میفرستد و جواب را برمیگرداند.

سیستمعاملهای سال ۲۰۲۶ مثل یک "مدیر ترافیک" هوشمند عمل میکنند که تصمیم میگیرند کدام پردازش کجا انجام شود.

جمعبندی: کوچک زیباست

ما در حال گذار از دوران "حیرت" به دوران "کاربرد" هستیم. هوش مصنوعی دیگر یک چتبات جادویی در مرورگر وب نیست؛ بلکه یک لایه نامرئی است که روی تمام سختافزارهای ما کشیده شده است. کوچک شدن مدلها باعث شده AI دموکراتیکتر، خصوصیتر و پایدارتر شود.

در سال ۲۰۲۶، قدرت یک دستگاه فقط به سرعت CPU آن نیست؛ بلکه به ضریب هوشی (IQ) تراشه آن بستگی دارد. و خوشبختانه، این هوش حالا کاملاً در اختیار شماست، درست در کف دستانتان.

نظر شما چیست؟ آیا برای شما مهم است که هوش مصنوعی آفلاین و خصوصی باشد؟ یا ترجیح میدهید به مدلهای قدرتمندتر ابری وصل باشید؟ در کامنتها برایمان بنویسید.