١. ثورة الذكاء الاصطناعي المحلي: لماذا يجب أن نترك Copilot؟

قد تتساءل: "إذا كان ChatGPT و GitHub Copilot يقدمان أداءً ممتازاً، فلماذا أتكبد عناء تثبيت نموذج ذكاء اصطناعي محلي (Local LLM)؟". الجواب يكمن في ثلاثة ركائز أساسية: الخصوصية، التكلفة، والاستقلالية.

كابوس الخصوصية

عندما تستخدم أدوات الذكاء الاصطناعي السحابية، يتم إرسال مقتطفات من الكود الخاص بك - وربما مفاتيح API حساسة أو منطق تجاري سري - إلى خوادم خارجية للمعالجة. بالنسبة للمشاريع الشخصية والهواة، قد لا تكون هذه مشكلة. ولكن بالنسبة لعمل الشركات أو المشاريع الناشئة الحساسة، فهذا يمثل خطراً أمنياً كبيراً. مع Local LLM مثل Devstral 2، بياناتك لا تغادر شبكتك المحلية (LAN) أبداً. يمكنك حرفياً فصل كابل الإنترنت، وسيعمل مساعدك الذكي بكفاءة تامة.

صفر تكلفة، صفر تأخير (Latency)

- لا فواتير شهرية: بمجرد امتلاكك للعتاد (Hardware)، تصبح عملية التوليد مجانية تماماً. وداعاً للاشتراكات المتكررة.

- السرعة: على بطاقات الرسوميات القوية (مثل RTX 3090 أو 4090)، يمكن لسرعة توليد النصوص (Tokens) أن تتجاوز سرعة واجهات برمجة التطبيقات (APIs) السحابية لأنك تقضي على تأخير الشبكة.

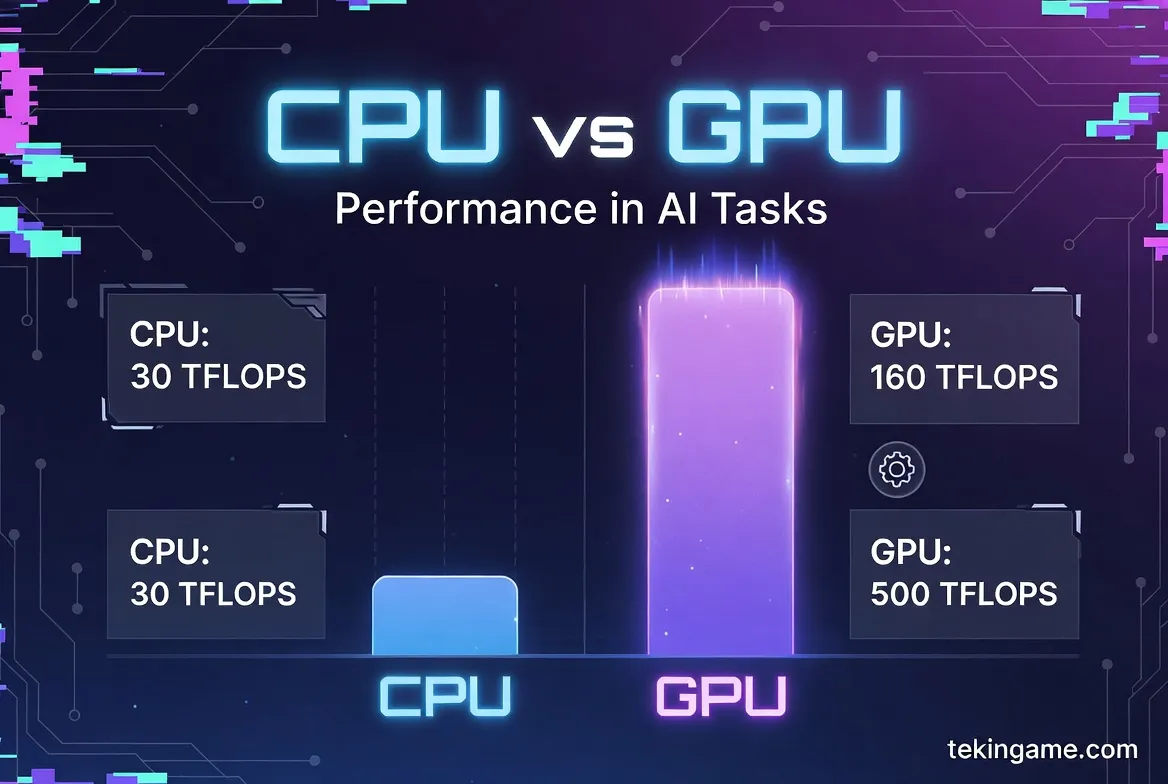

٢. متطلبات التشغيل: هل جهازك قوي بما يكفي؟

يختلف تشغيل نماذج اللغة الكبيرة (LLMs) عن تشغيل الألعاب. بينما تعتمد الألعاب على سرعة المعالج وكفاءة النوى، فإن نماذج الذكاء الاصطناعي متعطشة لشيء واحد: VRAM (ذاكرة الفيديو) وعرض النطاق الترددي للذاكرة.

الحد الأدنى للمتطلبات (لتشغيل نماذج بحجم 7B):

- بطاقة الرسوميات (GPU): تعتبر NVIDIA RTX 3060 (نسخة 12GB) هي نقطة البداية الذهبية. البطاقات ذات 8GB يمكن أن تعمل لكن بذاكرة سياق (Context Window) محدودة.

- الذاكرة العشوائية (RAM): لا تقل عن 16GB من نوع DDR4/DDR5.

- التخزين: قرص SSD NVMe ضروري لضمان سرعة تحميل النموذج.

مواصفات "تيكين جيم" المقترحة (لتجربة احترافية):

- GPU: بطاقة NVIDIA RTX 3090/4090 (بذاكرة 24GB). هذا يسمح لك بتشغيل نماذج أكبر أو نماذج قياسية مع ذاكرة سياق ضخمة جداً.

- RAM: يفضل 32GB أو 64GB. إذا امتلأت ذاكرة الفيديو، يمكن للنموذج استخدام ذاكرة النظام (رغم أن ذلك سيكون أبطأ).

- لمستخدمي Mac: أي جهاز بشريحة M1/M2/M3 مع ذاكرة موحدة 16GB على الأقل يعمل بشكل مذهل بفضل المعمارية الموحدة.

٣. حقيبة الأدوات: التعرف على Ollama و Devstral 2

في الماضي (قبل ستة أشهر فقط!)، كان تشغيل LLM يعني التعامل مع بيئات Python الافتراضية، ومكتبات PyTorch، وتعاريف CUDA المعقدة. كان الأمر صداعاً حقيقياً. هنا يأتي دور Ollama.

منصة Ollama هي أداة خفيفة وقوية تقوم بتجميع كل ما تحتاجه في ملف تنفيذي واحد. هي تتولى إدارة تعاريف البطاقة الرسومية، وأوزان النماذج، وخادم الـ API تلقائياً.

النموذج المختار: Devstral 2 (معمارية Mistral)

نحن نستخدم فلسفة "Devstral" - وهي نسخة محسنة ومخصصة للبرمجة من نموذج Mistral 7B الشهير. هذا النموذج يتفوق على فئته السعرية والحجمية، وغالباً ما يتجاوز أداء Llama 2 13B ويقترب من مستويات GPT-3.5 في اختبارات البرمجة بلغات Python و JavaScript و Rust.

٤. الخطوة الأولى: تثبيت المحرك (Ollama)

لنبدأ العمل الفعلي. سنشرح الخطوات لنظام Windows، وهي مشابهة جداً لنظامي macOS و Linux.

- توجه إلى الموقع الرسمي: ollama.com.

- اضغط على زر Download for Windows.

- قم بتشغيل ملف التثبيت. بمجرد الانتهاء، سترى أيقونة Ollama الصغيرة في شريط المهام (System Tray).

للتأكد من نجاح التثبيت، افتح موجه الأوامر (CMD) أو PowerShell واكتب الأمر التالي:

ollama --version

إذا ظهر لك رقم الإصدار (مثلاً 0.1.29)، فالمحرك يعمل بنجاح.

٥. الخطوة الثانية: تحميل العقل المدبر (نموذج Mistral/Devstral)

الآن نحتاج إلى تحميل "الدماغ". بما أن Devstral مبني على نواة Mistral، سنقوم بسحب أحدث نسخة محسنة من المكتبة.

في التيرمينال (Terminal)، اكتب الأمر التالي:

ollama run mistral

(ملاحظة: إذا كان لديك ملف `.gguf` مخصص لـ Devstral 2، يمكنك إنشاء Modelfile مخصص، ولكن لـ 99% من المستخدمين، نموذج Mistral الأساسي هو القاعدة المثالية).

ماذا سيحدث الآن؟

سيقوم Ollama بتحميل حوالي 4.1 جيجابايت من البيانات. بمجرد الانتهاء، سيضعك مباشرة في واجهة محادثة. جربه فوراً:

> Write a Python script to scrape headlines from a website using BeautifulSoup.

راقب مراوح بطاقة الرسوميات وهي تدور بينما يتم توليد النص محلياً!

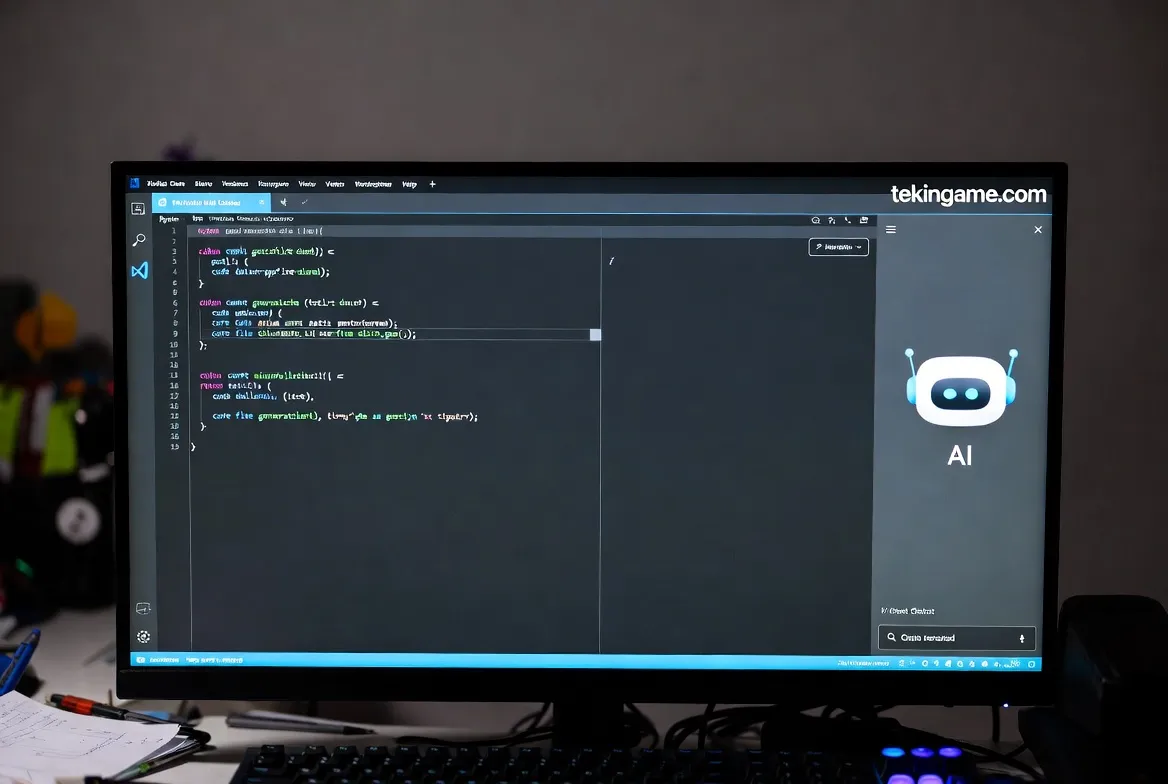

٦. الخطوة الثالثة: الربط مع VS Code (القاتل الحقيقي لـ Copilot)

الدردشة في الشاشة السوداء ممتعة، لكننا نريد ميزات الإكمال التلقائي و إعادة الهيكلة (Refactoring) داخل محرر الأكواد الخاص بنا. للقيام بذلك، نحتاج إلى إضافة Continue.

- افتح برنامج Visual Studio Code.

- اذهب إلى سوق الإضافات (Extensions Marketplace) وابحث عن كلمة "Continue".

- قم بتثبيت الإضافة المسماة "Continue - The open-source AI code assistant".

- بعد التثبيت، اضغط على شعار Continue في الشريط الجانبي (يسار أو يمين الشاشة).

- في أسفل لوحة المحادثة، اضغط على القائمة لاختيار الموديل، ثم اضغط "Add Model".

- اختر Ollama كمزود للخدمة (Provider).

- اختر خيار Autodetect. ستجده يكتشف تلقائياً نسخة Mistral التي قمت بتشغيلها.

كيف تستخدم قواك الخارقة الجديدة:

- الدردشة مع الكود: ظلل أي جزء من الكود واضغط

Ctrl + Lواسأل: "اشرح لي هذه الدالة" أو "أين الخطأ هنا؟". - التعديل المباشر: ظلل الكود واضغط

Ctrl + Iواكتب: "أعد كتابة هذا الكود ليكون أكثر كفاءة". شاهده وهو يعيد كتابة الكود أمام عينيك. - الإكمال التلقائي: تدعم إضافة Continue أيضاً اقتراحات الكود أثناء الكتابة (Ghost text) تماماً مثل Copilot.

٧. إعدادات المحترفين: زيادة الذاكرة وتخصيص الأوامر

إذا كنت تمتلك عتاداً قوياً (مثل تلك الذاكرة العشوائية 128GB التي نعلم أن بعضكم يمتلكها!)، يمكنك دفع النموذج لأقصى حدوده.

توسيع نافذة السياق (Context Window)

"نافذة السياق" هي مقدار الكود الذي يمكن للذكاء الاصطناعي "رؤيته" في وقت واحد. الافتراضي عادة هو 4096 توكن. لزيادة هذا الرقم:

- أوقف النموذج في التيرمينال (Ctrl+C).

- أنشئ ملفاً باسم

Modelfile(بدون امتداد). - ألصق هذا الكود بداخله:

FROM mistral PARAMETER num_ctx 16384

- نفذ الأمر:

ollama create devstral-pro -f Modelfile - الآن اختر "devstral-pro" في إعدادات VS Code. يمكنك الآن إطعامه ملفات ضخمة كاملة!

أمر النظام (System Prompt) للمطورين الكبار

لمنع الذكاء الاصطناعي من الثرثرة الزائدة وإجباره على التركيز على الكود فقط، غيّر "System Prompt" في إعدادات Continue إلى:

"You are an expert Senior Software Engineer skilled in Clean Code and Architecture. Answer concisely. Focus on performance, security, and scalability. Do not apologize, just provide the code."

٨. الخاتمة والأسئلة الشائعة

باتباعك لهذا الدليل، تكون قد استعدت استقلالك الرقمي بنجاح. أنت الآن تشغل أحدث نماذج الذكاء الاصطناعي على عتادك الخاص. لا تجسس، لا رسوم، ولا حدود.

أسئلة شائعة:

- هل هو بذكاء GPT-4؟ بصراحة؟ ليس تماماً بعد. GPT-4 هو نموذج بتريليونات المعاملات. Mistral/Devstral بحجم 7 مليار. ومع ذلك، للمهام البرمجية اليومية، هو كفؤ بشكل مدهش وأسرع بكثير.

- هل يمكنني استخدامه لـ C# أو C++؟ نعم! هذه النماذج مدربة على مجموعات بيانات ضخمة تشمل جميع لغات البرمجة الرئيسية تقريباً.

هل تمكنت من تشغيله؟ شاركنا نتائج اختبار السرعة وصور إعدادات جهازك (Setup) في التعليقات بالأسفل! أهلاً بك في مستقبل التطوير "الأوفلاين".

اشترك في نشرة تيكين جيم البريدية لكي لا تفوتك شروحاتنا القادمة حول تدريب النماذج الخاصة بك (Fine-tuning)!