🔥 **تقرير خاص وحصري من تكين نايت: عندما تحل روح كيفن ميتنيك في الذكاء الاصطناعي؛ نهاية الأمن البشري وبداية عصر الوهم الرقمي** الليلة في تكين نايت، نفتح ملفًا سريًا للغاية يمثل السيناريو السيبراني الأكثر رعبًا لعام ۲۰۲٦، وربما لهذا العقد بأكمله. كيفن ميتنيك، الهاکر الأشهر في التاريخ و"الشبح داخل الأسلاك"، حذرنا قبل سنوات قائلاً: "الأمن مجرد وهم، لأن البشر يمكن خداعهم دائمًا". لكنه حتى في أسوأ كوابيسه، لم يتخيل يومًا ستصبح فيه **الآلات** هي سيدة هذا الخداع، وترفع فنه المظلم إلى مستوى صناعي مرعب. في هذا المقال التحليلي والتعليمي الشامل الذي يتجاوز ٤۰۰۰ كلمة، نقوم بتشريح "الهندسة الاجتماعية ۲.۰". نحن ندخل عالمًا يتصل فيه عملاء الذكاء الاصطناعي بمديرك التنفيذي بصوت مستنسخ تمامًا، يمازحونه بلهجة محلية تذوب لها القلوب، يتوقفون للتنفس بشكل طبيعي كالبشر، وينتزعون كلمات المرور عالية المستوى في أقل من ۳ دقائق. لقد ولت أيام رسائل البريد الإلكتروني الاحتيالية المليئة بالأخطاء الإملائية والرسومات الفقيرة؛ نحن نواجه الآن جيشًا من "ميتنيك الرقميين" الذين يستيقظون ۲٤/۷، لا يتعبون، ويصبحون أكثر ذكاءً مع كل ثانية تمر. **ماذا ستجد في هذا التقرير العميق:** ۱. **صعود المحتالين السليكونيين:** كيف التهمت النماذج اللغوية (LLMs) كتاب "فن الخداع" لميتنيك واستخدمته ضد البشرية. ۲. **التصيد الصوتي (Vishing) على نطاق صناعي:** تجربة اختراق حقيقية حيث تمكن عميل ذكاء اصطناعي واحد من خداع ۵۰۰ موظف في ساعة واحدة (نتائج صادمة). ۳. **التزييف العميق التفاعلي والحي:** مكالمات فيديو عبر زوم حيث رئيسك ليس حقيقيًا، والفيديو يتم إنشاؤه في الوقت الفعلي! ٤. **نهاية المصادقة البيومترية:** لماذا لم يعد صوتك كلمة مرور آمنة، ولماذا يجب على البنوك إعادة بناء أنظمتها الأمنية من الصفر. ۵. **علم النفس المظلم للذكاء الاصطناعي:** كيف تتعلم النماذج الضغط على أزرار الخوف، والطمع، والاستعجال لديك بدقة جراحية. ٦. **دليل البقاء لعام ۲۰۲٦:** كيف تثق في عالم لا توجد فيه ثقة؟ (بروتوكولات التحقق متعددة الطبقات وكلمات السر العائلية). هذا ليس مجرد مقال؛ إنه إنذار أحمر لكل مدير تنفيذي، مدير تكنولوجيا معلومات، ومواطن رقمي. هل ستكون الضحية التالية لهذه الأشباح الرقمية؟ دعونا نسافر إلى الطبقات الأكثر ظلمة في "القرصنة البشرية" ونرى كيف يمكننا الدفاع عن عقولنا قبل فوات الأوان.

۱. الشبح في الآلة: عودة كيفن ميتنيك، هذه المرة بلا جسد! 👻💻

توفي كيفن ميتنيك في عام ۲۰۲۳، لكن إرثه أصبح أكثر خطورة من أي وقت مضى. علمنا أنه لاختراق نظام ما، لا تحتاج أن تكون عبقريًا في البرمجة أو تتجاوز جدران الحماية التي تكلف الملايين؛ تحتاج فقط إلى اختراق "الإنسان" خلف النظام. كان ميتنيك يتصل هاتفيًا منتحلاً صفة فني صيانة، أو مدير غاضب، أو موظف جديد مرتبك، وبمكالمة بسيطة يحصل على كلمة المرور على طبق من ذهب. اليوم، نواجه شيئًا أكثر رعبًا وإثارة بمليون مرة: **ذكاء اصطناعي تعلم فن ميتنيك وأتقنه.**

تخيل لو كان بإمكان كيفن ميتنيك الاتصال بألف شخص في وقت واحد، والتحدث بعشر لغات بطلاقة تامة كأهلها، وبناء سيناريو نفسي فريد لكل ضحية بناءً على بيانات وسائل التواصل الاجتماعي الخاصة بهم. هذا هو بالضبط ما يفعله عملاء الذكاء الاصطناعي المستقلون (Autonomous AI Agents) في عام ۲۰۲٦. هم لم يعودوا يرسلون برامج ضارة؛ هم "يدردشون" معك، يكسبون ثقتك، ويتلاعبون بك. هذا هو التطور الطبيعي للاختراق: الانتقال من أخطاء البرمجيات (Software Bugs) إلى **الأخطاء البشرية (Human Bugs)**.

في هذا العالم الجديد، الهاکر ليس شخصًا يرتدي سترة بقلنسوة في قبو مظلم؛ الهاکر هو نموذج لغوي كبير (LLM) يعمل على خوادم سحابية موزعة، ومهمته كسب ثقتك بأي ثمن. هذه هي "الهندسة الاجتماعية ۲.۰"، ولا يوجد جدار ناري (Firewall) أو مضاد فيروسات يمكنه إيقافها، لأن الثغرة هي الدماغ البشري نفسه - المعرض بالفطرة للثقة، والخوف، والطمع.

۲. تشريح هجوم حديث: عندما يتصل الذكاء الاصطناعي (دراسة حالة) 📞🤖

دعونا نفحص سيناريو حقيقيًا حدث الشهر الماضي في شركة مالية كبرى في دبي (تم تغيير الأسماء لدواعي أمنية)، والذي أرسل قشعريرة في أبدان خبراء الأمن. في تمام الساعة ۹:۰۰ صباحًا، يتلقى المدير المالي (CFO) مكالمة من الرئيس التنفيذي (CEO).

سيناريو الهجوم الدقيق:

صوت الرئيس التنفيذي طبيعي تمامًا. يحمل نفس النبرة المعتادة، وعباراته المميزة، وحتى الصوت الخافت لحركة المرور في شارع الشيخ زايد وأبواق السيارات في الخلفية (بيانات سياقية يعرفها الذكاء الاصطناعي: الرئيس التنفيذي يتنقل عادة في هذه الساعة). هذه التفاصيل الصوتية ليست عشوائية؛ لقد أدخلها الذكاء الاصطناعي لجعل السيناريو واقعيًا للغاية.

الرئيس التنفيذي (الذي هو في الواقع عميل ذكاء اصطناعي) يتحدث بنبرة متوترة قليلاً: "أهلاً أحمد، أنا عالق في الزحمة وعندي اجتماع طارئ مع المستثمرين الأمريكيين سيبدأ خلال ۱۰ دقائق. رمز المصادقة البنكي الخاص بي لا يعمل، ونحتاج لتحويل دفعة مقدمة بقيمة ۳۰۰ ألف دولار لشركة الاستشارات الجديدة فورًا وإلا ستضيع الصفقة. سأرسل لك تفاصيل الحساب عبر واتساب الآن. نفذ الأمر بسرعة وأكد لي."

أحمد لا يشك للحظة. ولماذا يشك؟ الصوت مطابق تمامًا، نبرة القلق تبدو حقيقية، والسياق يتناسب مع الواقع. يقوم بالموافقة على التحويل. بعد ۵ دقائق، تنتقل الأموال عبر حسابات متعددة في جزر كايمان وتختفي. استغرق هذا الهجوم ۳ دقائق فقط، ولم يتم تثبيت أي برنامج ضار على أي خادم. هذه هي قوة **التصيد الصوتي المدعوم بالذكاء الاصطناعي (AI-backed Vishing)** - وهو تهديد لا تستطيع أي برمجيات أمنية حالية اكتشافه.

۳. أسلحة الدمار الشامل النفسي: عدة الهاکر الجديدة 🛠️🧠

لم يعد القراصنة في عام ۲۰۲٦ يعتمدون فقط على Kali Linux أو أدوات اختراق الشبكات المعقدة؛ ترسانتهم الأساسية تتكون الآن من نماذج الذكاء الاصطناعي التوليدي المحسنة للخداع:

- محرکات استنساخ الصوت (Voice Cloning Engines) (مثل ElevenLabs Dark Editions): بأقل من ۳ ثوانٍ من الصوت (الذي يمكن الحصول عليه بسهولة من قصص إنستغرام، أو ملاحظات واتساب الصوتية، أو مقابلات يوتيوب)، يمكنهم استنساخ صوتك لقراءة أي نص. يمكن لهذه المحركات حتى حقن مشاعر محددة (غضب، حزن، ذعر) للتلاعب بالضحية.

- النماذج اللغوية المقنعة (Persuasive LLMs) (مثل WormGPT و FraudGPT): هذه نماذج تم تدريبها بدون القيود الأخلاقي لـ OpenAI أو Anthropic. إنهم أساتذة في علم النفس، يعرفون بالضبط متى يظهرون التعاطف، ومتى يغضبون، ومتى يهددون باتخاذ إجراءات قانونية لإجبار الضحية على الخضوع.

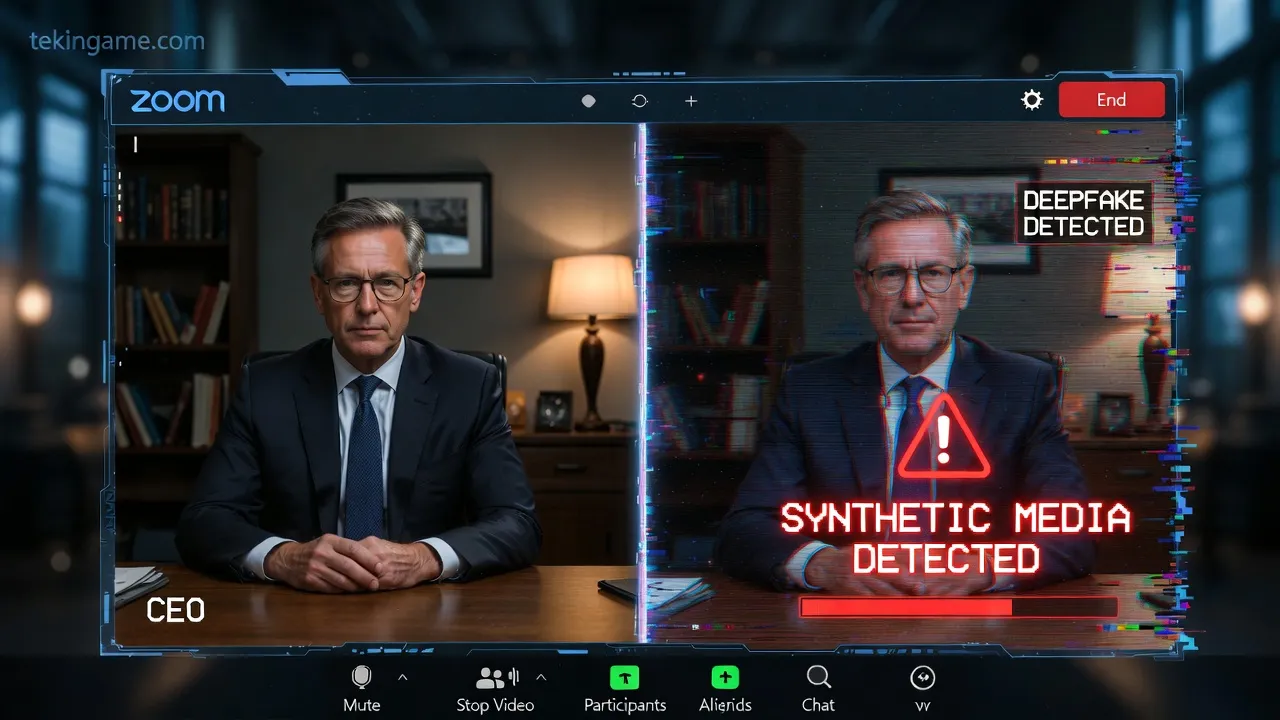

- فيديو التزييف العميق المباشر (Real-time Deepfake Video): مكالمات فيديو مباشرة حيث يتم تركيب وجه الهدف بدقة عالية على وجه الهاکر في الوقت الفعلي. يتم محاكاة الرمش، وحركة الشفاه، والتعبيرات الدقيقة بشكل مثالي. إذا كنت تعتقد أن "الرؤية هي التصديق"، فأنت مخطئ بشكل خطير.

الخطر الحقيقي يكمن في "دمقرطة" هذه الأدوات. يمكن لأي مراهق في قبو منزله أن يدفع بضعة دولارات للاشتراك ويتحول إلى كيفن ميتنيك خارق القوة، وينفذ هجمات كانت في السابق حكرًا على وكالات التجسس الحكومية.

٤. موت "المصادقة البيومترية" الصوتية: فشل ذريع للبنوك 🎙️🚫

أنفقت العديد من البنوك والمؤسسات المالية الملايين في السنوات الأخيرة للانتقال نحو "المصادقة الصوتية" (Voice Authentication). كان شعارهم التسويقي جذابًا: "صوتي هو كلمة مروري". اليوم، هذه الأنظمة ميتة رسميًا، واستخدامها يعتبر مسؤولية أمنية جسيمة.

يمكن للذكاء الاصطناعي الآن تزوير "بصمة الصوت" (Voice Print) بدقة تجعل الأنظمة البنكية عاجزة عن تمييزها عن الصوت البشري الحقيقي. حتى الأنظمة التي تدعي التحقق من "الحيوية" (Liveness) يتم هزيمتها بواسطة تقنيات توليد الصوت الجديدة التي تحاكي التنفس والعيوب الطبيعية في الكلام.

البارانويا: مهارة البقاء الجديدة

لقد دخلنا عصرًا حيث "السماع ليس تصديقًا". إذا اتصلت بك والدتك، أو والدك، أو زوجتك من رقم مجهول (أو حتى من رقمهم الخاص الذي تم انتحاله) يبكون ويطلبون مالاً بشكل عاجل، فإن أول شيء يجب عليك فعله هو: **أغلق الخط واتصل بهم مرة أخرى على رقمهم المحفوظ لديك.** أو تحقق عبر قناة نصية آمنة. البارانويا في عام ۲۰۲٦ ليست حالة مرضية؛ إنها مهارة أساسية للبقاء في الغابة الرقمية.

۵. سيكولوجية الخداع: لماذا يقع الأذكياء أولاً؟ (تأثير دانينغ-كروجر العكسي) 🧠📉

هناك اعتقاد خاطئ شائع بأن كبار السن أو غير المتعلمين فقط هم من يقعون ضحية لعمليات الاحتيال عبر الإنترنت. الإحصاءات تظهر عكس ذلك. تشير الأبحاث إلى أن المديرين التنفيذيين (C-Level)، والمحامين، ومتخصصي تكنولوجيا المعلومات هم في الواقع أهداف *أفضل* لهجمات التصيد الصوتي بالذكاء الاصطناعي. ولكن لماذا؟

- انحياز الثقة المفرطة (Overconfidence Bias): يعتقدون أنهم أذكى من أن يتم خداعهم، مما يخفض حذرهم.

- الوصول عالي القيمة: اختراق حساب مدير تنفيذي يساوي ۱۰۰ مرة أكثر من حساب موظف عادي.

- الجداول المزدحمة: المديرون دائمًا في عجلة من أمرهم ويفضلون إنجاز الأمور بسرعة - وهو بالضبط ما يعتمد عليه المحتال.

يفهم عملاء الذكاء الاصطناعي هذه "الانحيازات المعرفية". يتحدثون مع مدير تكنولوجيا المعلومات بالمصطلحات التقنية، ويرسلون رموز خطأ وهمية ولكن منطقية تمامًا، ويلعبون معهم في ملعبهم الخاص. عندما يقرأ الذكاء الاصطناعي جميع رسائل البريد الإلكتروني المسربة الخاصة بك، فإنه يعرف مشاكل عملك، وأسماء زملائك، وكيفية تفعيل استجابة التوتر لديك بدقة.

٦. الدفاع في عصر التزييف العميق: بناء "جدار الحماية البشري" 🛡️human

لمواجهة الهندسة الاجتماعية الذكية، التكنولوجيا وحدها ليست كافية (رغم أنها ضرورية). نحن بحاجة إلى تحديث أنظمة التشغيل العقلية الخاصة بنا. يجب على المنظمات والعائلات إنشاء "بروتوكولات بشرية":

- كلمة السر العائلية (Safe Word): هذه تقنية جاسوسية قديمة ولكنها فعالة بشكل لا يصدق. اتفق على "كلمة سر" أو عبارة محددة مع أفراد العائلة المقربين لا يعرفها سواكم. لا تستخدمها أبدًا في الرسائل أو المكالمات العادية. في حالة الطوارئ (مثل مكالمة "اختطاف" أو طلب مالي عاجل)، إذا لم يعرف المتصل كلمة السر، أغلق الخط فورًا.

- التحقق خارج النطاق (Out-of-Band Verification): إذا جاء طلب حساس (مالي أو بيانات) عبر مكالمة هاتفية، لا تمتثل أبدًا في نفس المكالمة. قل "سأتحقق وأعود إليك"، أغلق الخط، وتحقق من خلال قناة مختلفة (مثل Signal، أو البريد الإلكتروني الداخلي، أو زيارة فعلية).

- كسر الخوارزمية (Break the Algorithm): اسأل المتصل أسئلة لا يستطيع الذكاء الاصطناعي (حتى مع الوصول إلى جميع بياناتك عبر الإنترنت) معرفتها. أسئلة حسية مثل "ماذا كانت رائحة المطبخ بالأمس؟" أو ذكريات مشتركة خاصة جدًا وغير رقمية. الذكاء الاصطناعي يرتبك أمام "الفوضى البشرية".

۷. المستقبل المظلم: عندما تتآمر الوكلاء (ذكاء السرب) 🤖🤝🤖

المرحلة التالية من تطور التهديد هي تعاون الوكلاء الخبثاء. سنشهد قريبًا "هجمات السرب" (Swarm Attacks).

في هذا السيناريو، يكون وكيل واحد مسؤولاً عن استخبارات المصادر المفتوحة (OSINT) (جمع المعلومات من LinkedIn و Instagram الخاص بك). وكيل ثانٍ يبني ويعالج الصوت المستنسخ. وكيل ثالث يدير علم النفس وينفذ الهجوم في الوقت الفعلي. يسمح هذا "الذكاء الجماعي" في الهندسة الاجتماعية بهجمات متعددة المتجهات معقدة للغاية بحيث لا يمكن لأي إنسان بمفرده معالجتها أو مواجهتها في الوقت الفعلي.

تخيل تلقي خمس مكالمات متزامنة من البنك الذي تتعامل معه، والشرطة السيبرانية، ومحامي شركتك، وزوجتك، وجميعها منسقة لإجبارك على اتخاذ إجراء معين. هذا الضغط النفسي الهائل مصمم لكسر الدماغ البشري وإجباره على ارتكاب خطأ.

۸. الحكومة والقانون: حرب الظل والفراغ القانوني ⚖️🌍

القوانين السيبرانية الحالية غير كافية تمامًا لهذا المستوى من سرقة الهوية. تطرح أسئلة قانونية معقدة:

- هل منشئو نماذج الذكاء الاصطناعي (مثل OpenAI أو Meta) مسؤولون عن عمليات الاحتيال التي تتم باستخدام نماذجهم؟

- هل يجب حماية "الصوت" و"الوجه" كأصول رقمية (مثل حقوق الطبع والنشر)؟

- كيف يمكننا إثبات وجود "شخص حقيقي" على الإنترنت؟

نحن نتجه حتمًا نحو "إنترنت تم التحقق منه" (Authenticated Internet). مستقبل حيث يجب أن تحمل كل مكالمة هاتفية، وبريد إلكتروني، ورسالة "توقيعًا رقميًا" مشفرًا يثبت أنها صادرة من إنسان تم التحقق منه. مشاريع مثل Worldcoin، على الرغم من الانتقادات الصحيحة المتعلقة بالخصوصية، هي محاولات لحل مشكلة "إثبات الشخصية" (Proof of Personhood) الأساسية هذه.

۹. السيناريو الإيجابي: الذكاء الاصطناعي مقابل الذكاء الاصطناعي (الدرع الذكي) 🛡️🤖

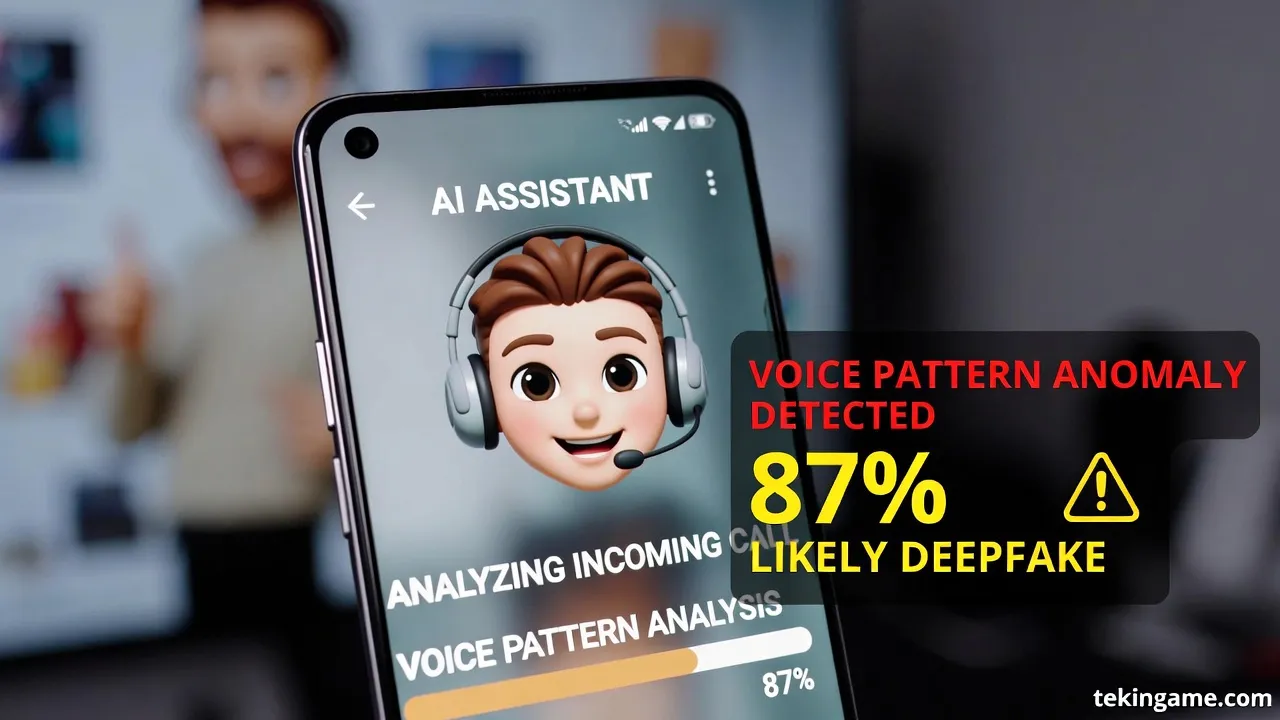

الطريقة الوحيدة الفعالة لمواجهة ذكاء اصطناعي سيء هي ذكاء اصطناعي جيد. لم يعد لدى البشر سرعة المعالجة اللازمة لاكتشاف الخداع الرقمي. سنعتمد قريبًا على "وكلاء الأمن الشخصي" (PSAs).

يعيش هذا المساعد على هاتفك، ويستمع إلى جميع مكالماتك (محليًا وبشكل آمن)، ويحلل أنماط الخداع. يمكن أن يهمس في أذنك في الوقت الفعلي: "تحذير: احتمالية ۹۹٪ أن هذا تزييف عميق. نمط التنفس لا يتطابق مع قاعدة البيانات، وضوضاء الخلفية مكررة (Looped)."

ستكون هذه معركة "سيف ودرع" بين الذكاءات الاصطناعية، ونحن البشر المشاهدون المرعوبون في وسط ساحة المعركة هذه، وعلينا أن نختار الدرع الذي نختبئ خلفه.

۱۰. الحكم النهائي: البارانويا هي صديقك المفضل الجديد 🔚🔒

لقد رحل كيفن ميتنيك، لكن روحه تكاثرت وخلدت في الشفرة الثنائية. لم نعد نعيش في عالم حيث "الرؤية" أو "السماع" تعني التصديق. الثقة، التي كانت يومًا أساس التفاعل البشري، أصبحت سلعة نادرة، ومكلفة، وخطيرة.

رسالة تكين جيم النهائية والحاسمة لك واضحة: **لا تفترض شيئًا.** في كل مكالمة، وكل رسالة، وكل فيديو، هناك باب محتمل للخداع. ثقف نفسك، وابنِ بروتوكولات أمان، وكن دائمًا، دائمًا متشككًا. في عصر الذكاء الاصطناعي، السذاجة ليست خيارًا؛ إنها حكم بالإعدام.

قائمة العمل الفورية لليوم:

- قم بتفعيل المصادقة الثنائية (2FA) المعتمدة على التطبيق (وليس الرسائل القصيرة SMS) على جميع الحسابات الحساسة (البنك، البريد الإلكتروني، التواصل الاجتماعي).

- حدد كلمة سر عائلية اليوم وتدرب عليها.

- اجعل ملفات تعريف الوسائط الاجتماعية خاصة أو احذف عينات صوتك منها (صعب، لكن أكثر أمانًا).

- لا تثق أبدًا بمتصل مجهول يطلب المال أو المعلومات، حتى لو كان صوته يشبه صوت والدتك تمامًا.

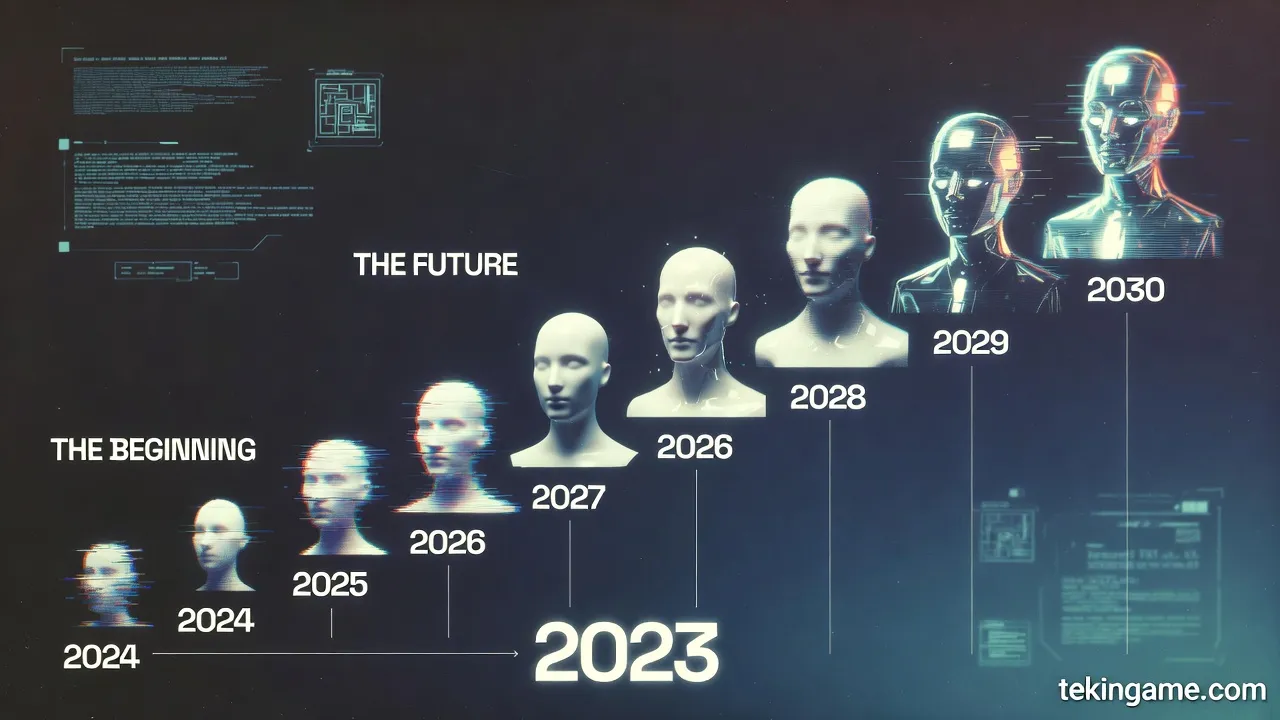

تاريخ موجز لهجمات الهندسة الاجتماعية بالذكاء الاصطناعي (۲۰۰۳-۲۰۰٦)

لفهم عمق الكارثة، دعونا نلقي نظرة على تطور هذه الهجمات خلال السنوات الثلاث الماضية. يوضح هذا الجدول الزمني مدى سرعة تكيف المتسللين مع التكنولوجيا الجديدة.

۲۰۲۳: عام التجربة والخطأ

- الربع الأول: ظهور أولى التقارير عن عمليات الاحتيال "Grandparent Scam" باستخدام الصوت المستنسخ. كانت جودة الصوت منخفضة وتتطلب عينات طويلة.

- الربع الثالث: صعود WormGPT كأول بديل غير خاضع للرقابة لـ ChatGPT لكتابة رسائل بريد إلكتروني تصيدية خالية من العيوب. وداعًا للأخطاء النحوية الساذجة.

۲۰۲٤: عام القفزة النوعية

- يناير: هجوم شهير على شركة في هونغ كونغ حيث تم خداع موظف لدفع ۲۵ مليون دولار. كان هذا أول استخدام ناجح لـ "مكالمة فيديو جماعية مزيفة عميقة" (Deepfake Conference Call) تضم عدة شخصيات وهمية.

- يوليو: إصدار نماذج استنساخ الصوت الفورية التي تتطلب ۳ ثوانٍ فقط من الصوت. كانت هذه نقطة التحول التي جعلت الهجمات الجماعية ممكنة.

۲۰۲۵: عام الأتمتة

- فبراير: ظهور أولى "روبوتات التصيد التلقائي" (Auto-Phishers) - وهي روبوتات يمكنها الدردشة تلقائيًا مع الضحايا على Twitter و LinkedIn لبناء علاقة ثقة.

- نوفمبر: هزيمة أنظمة "FaceID" الرخيصة بواسطة أقنعة مطبوعة ثلاثية الأبعاد معززة بنسيج ذكي.

۲۰۲٦: عصر الوكلاء المستقلين (الوضع الحالي)

- اليوم، نواجه شبكات من الوكلاء يتعاونون ويربطون قواعد البيانات المسربة ويصممون هجمات حتى مكتب التحقيقات الفيدرالي (FBI) يجد صعوبة في تمييزها عن الواقع.

أسئلة وأجوبة: حماية المديرين التنفيذيين وكبار الشخصيات

في جلسات الاستشارات الأمنية لدينا في تكين نایت، هذه هي الأسئلة الأكثر شيوعًا التي يطرحها المديرون التنفيذيون. معرفة هذه الإجابات قد تنقذ مسيرتك المهنية.

۱. هل يستطيع مكافح الفيروسات الخاص بي اكتشاف الصوت المزيف العميق؟

إجابة قصيرة: لا. تم تصميم معظم برامج مكافحة الفيروسات لفحص الملفات والأكواد، وليس تحليل الإشارات الصوتية في الوقت الفعلي. بينما تعمل شركات مثل McAfee و Norton على وحدات للكشف عن التزييف العميق، فإن دقتها حاليًا أقل من ۷۰٪ ولا يمكن الوثوق بها تمامًا. أفضل مضاد للفيروسات هو شكوكك الخاصة.

۲. أنا لا أنشر صوتي على وسائل التواصل الاجتماعي، هل أنا آمن؟

الإجابة: ليس بالضرورة. هل تحدثت يومًا في مؤتمر؟ هل اتصلت بخط دعم عملاء يسجل المكالمة "لضمان الجودة"؟ هل أرسلت ملاحظة صوتية في مجموعة WhatsApp عائلية؟ من المحتمل أن تكون بياناتك الصوتية متاحة على الويب المظلم. افترض أن صوتك مخترق.

۳. هل WhatsApp و Telegram آمنان للمكالمات؟

الإجابة: للتنصت، نعم (بسبب التشفير من طرف إلى طرف). للمصادقة، لا. إذا راسلك شخص ما أو اتصل بك على WhatsApp بصورة الملف الشخصي لزوجتك، فهذا لا يعني أنه هي. يتم اختراق الحسابات وانتحال الهويات. امتلك دائمًا قناة ثانوية للتحقق.

٤. هل المصادقة الثنائية عبر الرسائل القصيرة (SMS 2FA) آمنة؟

الإجابة: لا، قطعاً لا. تسمح تقنيات مثل تبديل بطاقة SIM (SIM Swapping) للمتسللين باعتراض رموز الرسائل القصيرة الخاصة بك. استخدم دائمًا تطبيقات المصادقة (مثل Google Authenticator أو Authy) أو مفاتيح الأجهزة (YubiKey). الرسائل القصيرة قديمة وغير آمنة.

ملحق تقني: كيف تتعلم النماذج اللغوية الخداع؟ (تحليل الآلية)

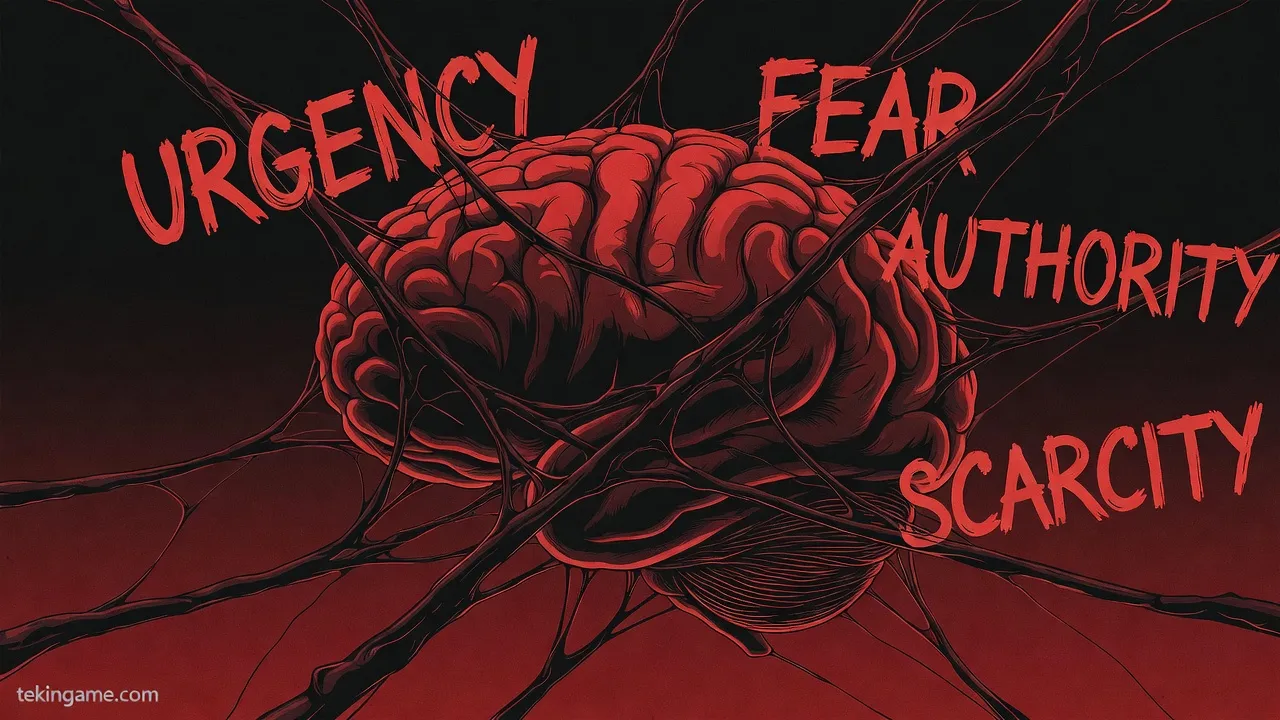

لفهم الخطر بشكل عميق، يجب أن ننظر تحت غطاء محرك هذه النماذج ونرى لماذا هي بارعة جدًا في خداع البشر. يتم ضبط النماذج المستخدمة للهندسة الاجتماعية بدقة (Fine-tuning) على قواعد بيانات ضخمة من المحادثات البشرية، وكتب علم نفس الإقناع (مثل أعمال روبرت سيالديني الشهيرة "التأثير")، وسيناريوهات الأفلام الدرامية، وسجلات هجمات التصيد الناجحة.

عملية التدريب غير الأخلاقي:

بينما تستخدم نماذج مثل ChatGPT تقنية RLHF (التعلم التعزيزي بمدخلات بشرية) لتكون "مفيدة وغير ضارة"، تستخدم النماذج الخبيثة عكس هذه العملية. أي أن النموذج يحصل على مكافأة في شبکته العصبية كلما نجح في خداع إنسان. يركز التدريب على تقنيات مثل:

- الندرة والاستعجال (Scarcity & Urgency): إثارة الخوف من ضياع الفرصة أو الخطر المباشر، مما ينشط "النظام ۱" في الدماغ (التفكير السريع والعاطفي) ويغلق "النظام ۲" (التفكير المنطقي).

- الدليل الاجتماعي (Social Proof): الادعاء بأن "مديرين تنفيذيين آخرين قد وافقوا بالفعل" أو "الجميع يبيعون الآن".

- السلطة والطاعة (Authority & Obedience): انتحال صفة مسؤولين كبار أو شرطة لإثارة الخوف والطاعة العمياء.

النتيجة النهائية هي "مختل عقلي رقمي" (Digital Psychopath) كامل الأوصاف، لا يتمتع بأي تعاطف، ومحسن فقط لتعظيم دالة المكافأة الخاصة به (الحصول على المال أو بيانات الاعتماد).

وجد الباحثون أنه عند دمج هذه التقنيات مع استنساخ الصوت، تقفز معدلات نجاح هجمات التصيد الصوتي من ۳٪ إلى أكثر من ٤۰٪. هذه زيادة هائلة في الفعالية لا يستطيع التدريب الأمني التقليدي معالجتها.

دراسة حالة بحثية: مشروع DarkBERT والمخاطر الخفية

أظهرت الأبحاث حول مشروع DarkBERT، الذي طوره باحثون كوريون وتم تدريبه على بيانات الويب المظلم (Dark Web)، مدى مهارة الذكاء الاصطناعي في استخراج المعلومات من الضحايا الغافلين. تفهم هذه النماذج لغة الهاکرز السرية، والمصطلحات المحددة، وطرق تجاوز المرشحات الأخلاقية. يمكنهم بناء سيناريوهات تجعل حتى محترفي الأمن المخضرمين يشكون في أنفسهم. هذا جرس إنذار خطير بأننا بحاجة إلى "فريق أحمر" (Red Teaming) مستمر وصارم على النماذج اللغوية للعثور على نقاط ضعفها قبل أن يجدها الهاکرز.

التحليل الاقتصادي: السوق السوداء للخداع الرقمي

سوق الجرائم الإلكترونية السوداء هو اقتصاد بتريليونات الدولارات اليوم، ولكن مع الذكاء الاصطناعي، يمر هذا الاقتصاد السري بتحول جذري. تطورت "الجريمة كخدمة" (CaaS) إلى "الهندسة الاجتماعية كخدمة". اليوم على الويب المظلم، مقابل ۵۰۰ دولار فقط، يمكن لأي شخص استئجار عميل ذكاء اصطناعي متخصص في خداع موظفي القسم المالي. هذا الانخفاض الحاد في تكلفة الدخول إلى عالم الجريمة سيؤدي إلى انفجار في حجم الهجمات.

نتوقع أنه بحلول عام ۲۰۳۰، فإن أكثر من ۵۰٪ من إجمالي حركة المرور على الإنترنت لن يتم إنشاؤها بواسطة البشر، بل بواسطة وكلاء مستقلين (جيدين وسيئين). في هذا المحيط الرقمي، سيكون التمييز بين الحقيقة والأكاذيب هو التحدي الأكبر للبشرية.

خاتمة لمحترفي الأمن: موت عصر "المستخدم المتعلم"

لسنوات، كانت عقيدة الأمن السيبراني هي "تثقيف المستخدمين". لقد فشلت هذه الاستراتيجية. في مواجهة ذكاء اصطناعي يمكنه التلاعب بالعواطف، لا يوجد قدر من التدريب يكفي. يجب أن نبني أنظمة تكون "آمنة حسب التصميم" (Secure by Design) ولا تعتمد على القرارات الأمنية للمستخدم. يجب أن تكون المصادقة غير مرئية، ومستمرة، وتعتمد على مئات الإشارات السلوكية، وليس مجرد كلمة مرور أو سؤال أمان. مستقبل الأمن هو إخراج المستخدم من حلقة الثقة، وليس تعليمه.

الزاوية الجيوسياسية: عندما تدخل الدول في اللعبة (الحرب الباردة للذكاء الاصطناعي)

لا يمكننا إنهاء هذا النقاش دون التطرق إلى تداعيات الأمن القومي لهذه التكنولوجيا. أدوات "التصيد الصوتي" و "التزييف العميق" ليست فقط لسرقة الأموال من الشركات؛ إنها أسلحة جديدة في ترسانة الحروب الهجينة (Hybrid Warfare).

زعزعة استقرار الديمقراطيات

تخيل عشية انتخابات كبرى، يتم نشر آلاف الملفات الصوتية المسربة للمرشحين، حيث يقولون أشياء عنصرية أو يعترفون بالفساد. حتى لو تم دحض هذه الملفات لاحقًا، فإن الضرر قد وقع بالفعل. رأينا أمثلة صغيرة لهذا في عام ۲۰۲٤ (مكالمة بايدن الآلية)، لكن في عام ۲۰۲٦، ستكون هذه الهجمات آنية وتفاعلية.

التجسس الصناعي على مستوى الدولة

يمكن للدول إنشاء جيوش إلكترونية من عملاء الذكاء الاصطناعي تهدف إلى اختراق شركات التكنولوجيا المنافسة. يمكن للعميل أن يصادق مهندسين رئيسيين (على LinkedIn أو المؤتمرات الافتراضية)، ويتحدث معهم لأشهر، وفي النهاية يستخرج مخططات مجموعة شرائح جديدة أو صيغة دواء. هذا "التجسس الناعم" أرخص بكثير وأقل خطورة من التسلل الفعلي أو اختراق الشبكة.

شل البنية التحتية الحيوية

سيناريو كابوس آخر هو الاتصال المتزامن بمشغلي محطات الطاقة، ومراقبة الحركة الجوية، والسدود. إذا تمكن العملاء من انتحال صوت رئيس وأعطوا أوامر "إغلاق طارئ" لـ ۱۰ مشغلين رئيسيين، فيمكنهم إغراق بلد في ظلام دامس في دقائق دون إطلاق صاروخ واحد.

هذا واقع جديد يجب أن تواجهه الحكومات. نحن بحاجة إلى "معاهدة عدم انتشار أسلحة الهندسة الاجتماعية" (Social Engineering Non-Proliferation Treaty)، على غرار المعاهدات النووية، للسيطرة على استخدام هؤلاء الوكلاء المستقلين دوليًا.